Innehållsförteckning

Viktiga takeaways

- Generalisering är viktigt i djupinlärning för att säkerställa korrekta förutsägelser med nya data. Zero-shot-inlärning hjälper till att uppnå detta genom att tillåta AI att använda befintlig kunskap för att göra korrekta förutsägelser om nya eller osynliga klasser utan märkta data.

- Zero-shot learning härmar hur människor lär sig och bearbetar data. Genom att tillhandahålla ytterligare semantisk information kan en förtränad modell exakt identifiera nya klasser, precis som en människa kan lära sig att identifiera en gitarr med ihålig kropp genom att förstå dess egenskaper.

- Zero-shot-inlärning förbättrar AI genom att förbättra generalisering, skalbarhet, minska överanpassning och vara kostnadseffektiv. Det gör det möjligt för modeller att tränas på större datamängder, få mer kunskap genom överföringsinlärning, få en bättre kontextuell förståelse och minska behovet av omfattande märkta data. I takt med att AI utvecklas kommer zero-shot-inlärning att bli ännu viktigare för att hantera komplexa utmaningar inom olika områden.

Ett av de största målen med djupinlärning är att träna modeller som har fått generaliserad kunskap. Generalisering är viktigt eftersom det säkerställer att modellen har lärt sig meningsfulla mönster och kan göra korrekta förutsägelser eller beslut när den ställs inför nya eller osynliga data. Att träna sådana modeller kräver ofta en avsevärd mängd märkt data. Sådana uppgifter kan dock vara kostsamma, arbetskrävande och ibland omöjliga.

Zero-shot learning implementeras för att överbrygga detta gap, vilket gör att AI kan använda sin befintliga kunskap för att göra ganska exakta förutsägelser trots bristen på märkt data.

Vad är Zero-Shot Learning?

Zero-shot learning är en specifik typ av överföringsinlärningsteknik. Den fokuserar på att använda en förutbildad modell för att identifiera nya eller aldrig tidigare sett klasser helt enkelt genom att tillhandahålla extra information som beskriver detaljerna i den nya klassen.

Genom att använda en modells allmänna kunskap om vissa ämnen och ge den extra semantik om vad den ska leta efter, bör den kunna peka ut ganska exakt vilket ämne den har till uppgift att identifiera.

Låt oss säga att vi måste identifiera en zebra. Men vi har ingen modell som kan identifiera sådana djur. Så vi får en redan existerande modell tränad att identifiera hästar och berätta för modellen att hästar med svarta och vita ränder är zebror. När vi börjar dra slutsatser om modellen genom att tillhandahålla bilder av zebror och hästar, finns det en god chans att modellen identifierar varje djur korrekt.

Liksom många tekniker för djupinlärning härmar noll-shot learning hur människor lär sig och bearbetar data. Människor är kända för att vara naturliga nollskottslärare. Om du fick i uppdrag att hitta en ihålig gitarr i en musikaffär kan du ha problem med att leta efter en. Men när jag väl berättar att en ihålig kropp i grunden är en gitarr med ett f-format hål på ena eller båda sidorna, kommer du förmodligen att hitta en direkt.

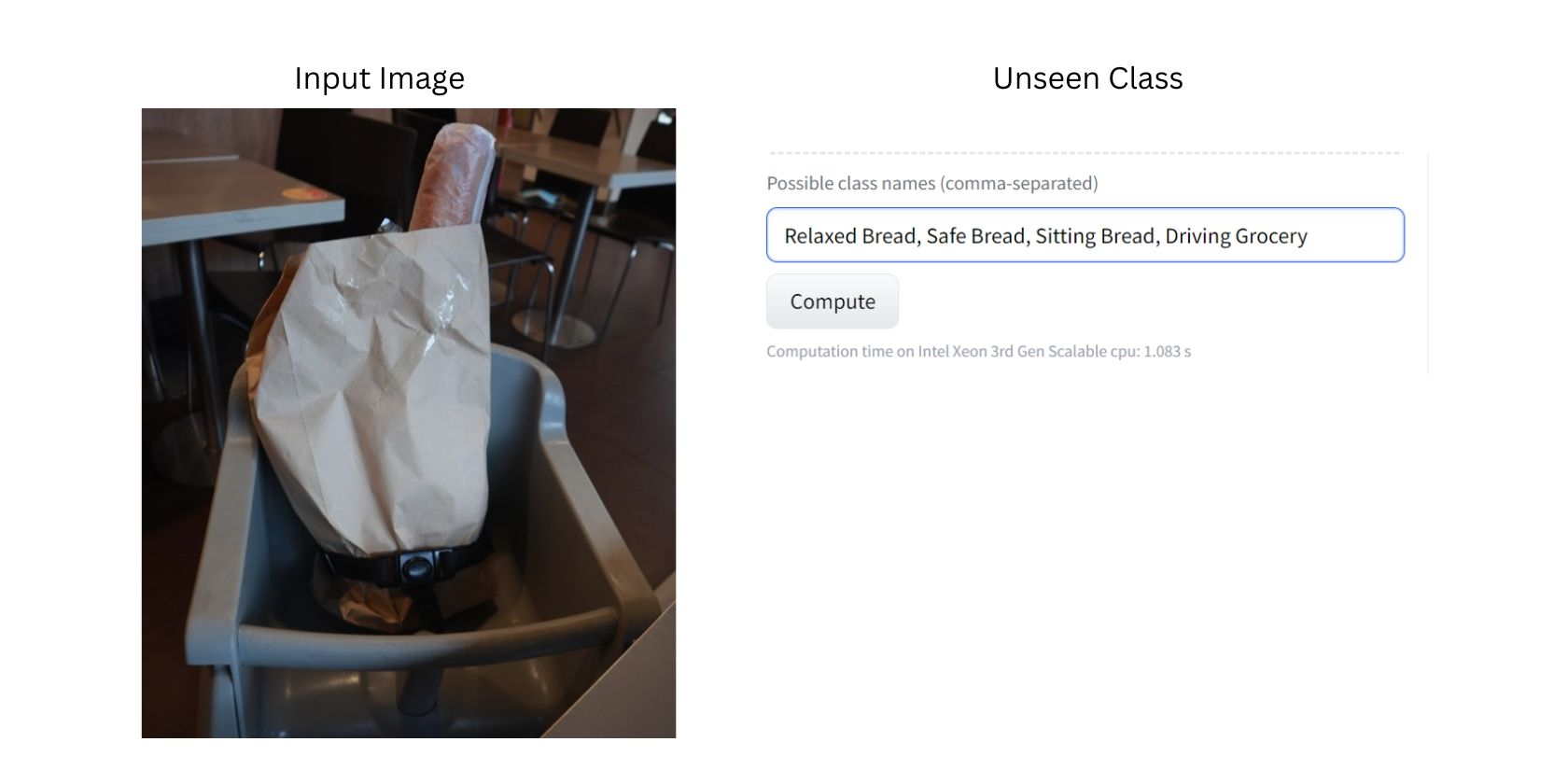

För ett verkligt exempel, låt oss använda noll-shot-klassificeringsappen från LLM-värdwebbplatsen Hugging Face med öppen källkod med clip-vit-large-modellen.

Det här fotot visar en bild av bröd i en matkasse fastspänd på en barnstol. Eftersom modellen tränades på en stor datamängd av bilder, kan modellen troligen identifiera varje föremål på bilden, som bröd, matvaror, stolar och säkerhetsbälten.

Nu vill vi att modellen ska klassificera bilden med tidigare osynliga klasser. I det här fallet skulle romanen eller de osynliga klasserna vara ”Avslappnat bröd”, ”Säkert bröd”, ”Sittande bröd”, ”Köra mataffär” och ”Säker mataffär.”

Observera att vi medvetet har använt ovanliga osynliga klasser och bilder för att demonstrera effektiviteten av nollbildsklassificering på en bild.

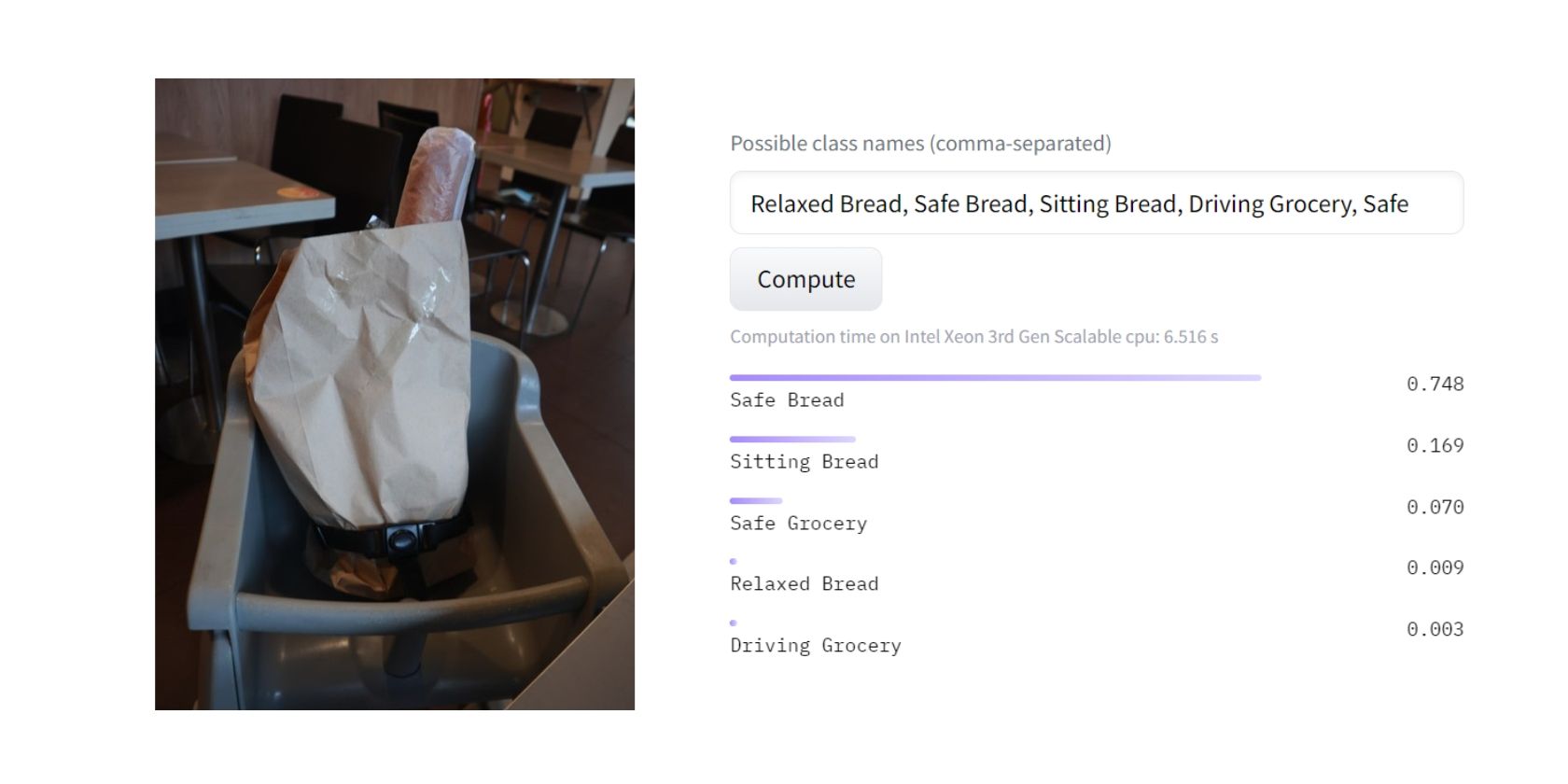

Efter att ha dragit slutsatsen av modellen kunde den med cirka 80 % säkerhet klassificera att den mest lämpliga klassificeringen för bilden var ”Säkert bröd”. Detta beror troligen på att modellen tror att en barnstol är mer för säkerheten än att sitta, koppla av eller köra bil.

Grymt bra! Jag skulle personligen hålla med om modellens resultat. Men exakt hur kom modellen fram till en sådan effekt? Här är en allmän syn på hur zero-shot learning fungerar.

Hur Zero-Shot Learning fungerar

Zero-shot learning kan hjälpa en förutbildad modell att identifiera nya klasser utan att tillhandahålla märkta data. I sin enklaste form görs noll-shot-inlärning i tre steg:

1. Förberedelse

Zero-shot inlärning börjar med att förbereda tre typer av data

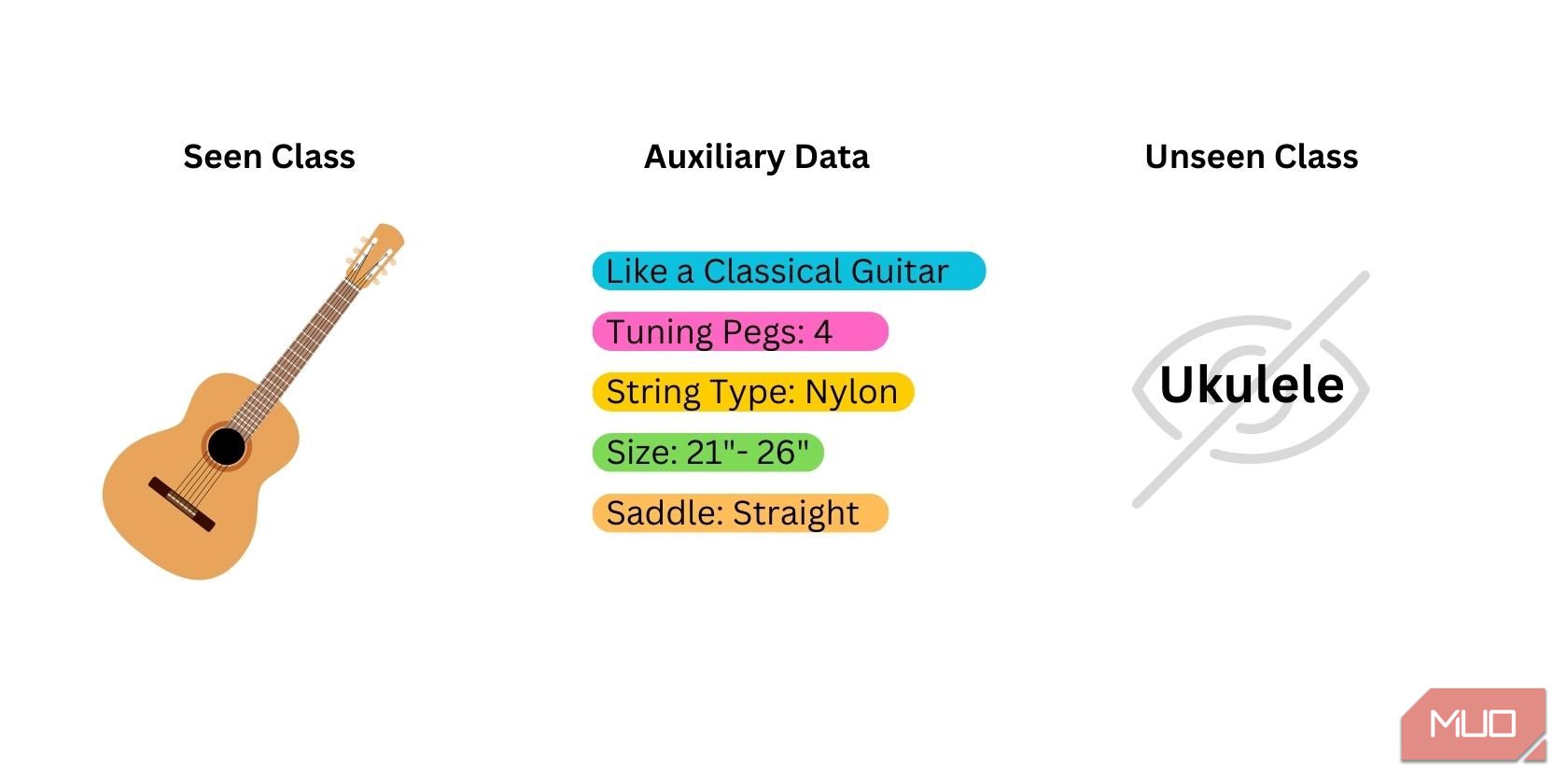

- Seen Class: Data som används för att träna den förtränade modellen. Modellen ger redan sedda klasser. De bästa modellerna för noll-shot-inlärning är modeller som tränas i klasser som är nära relaterade till den nya klassen du vill att modellen ska identifiera.

- Unseen/Novel Class: Data som aldrig användes under utbildningen av modellen. Du måste kurera dessa data själv eftersom du inte kan få detta från modellen.

- Semantiska/hjälpdata: Extra databitar som kan hjälpa modellen att identifiera den nya klassen. Detta kan vara i ord, fraser, ordinbäddningar eller klassnamn.

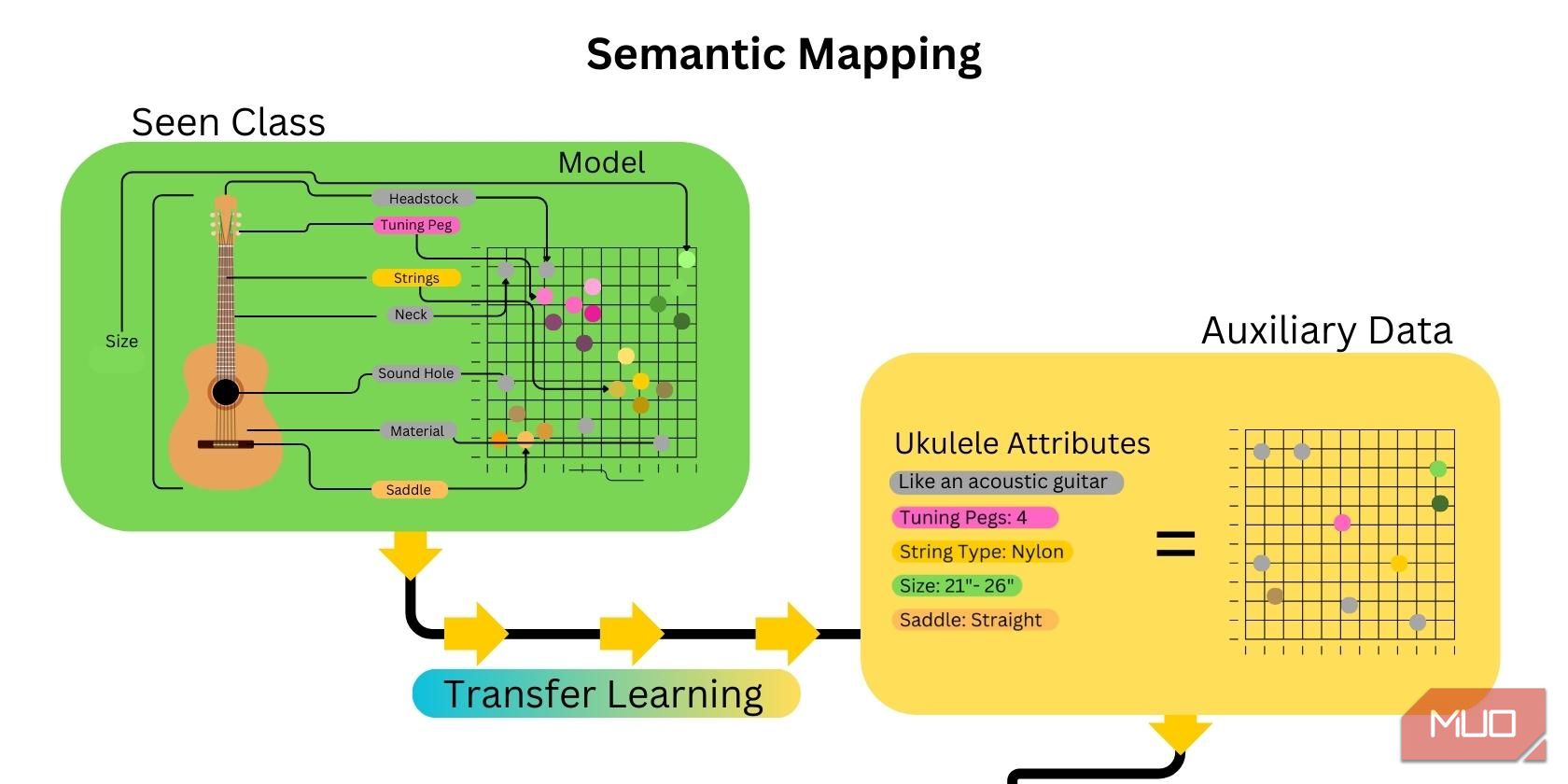

2. Semantisk kartläggning

Nästa steg är att kartlägga funktionerna i den osynliga klassen. Detta görs genom att skapa ordinbäddningar och göra en semantisk karta som länkar attributen eller egenskaperna för den osynliga klassen till de hjälpdata som tillhandahålls. AI-överföringsinlärning gör processen mycket snabbare, eftersom många attribut relaterade till den osynliga klassen redan har kartlagts.

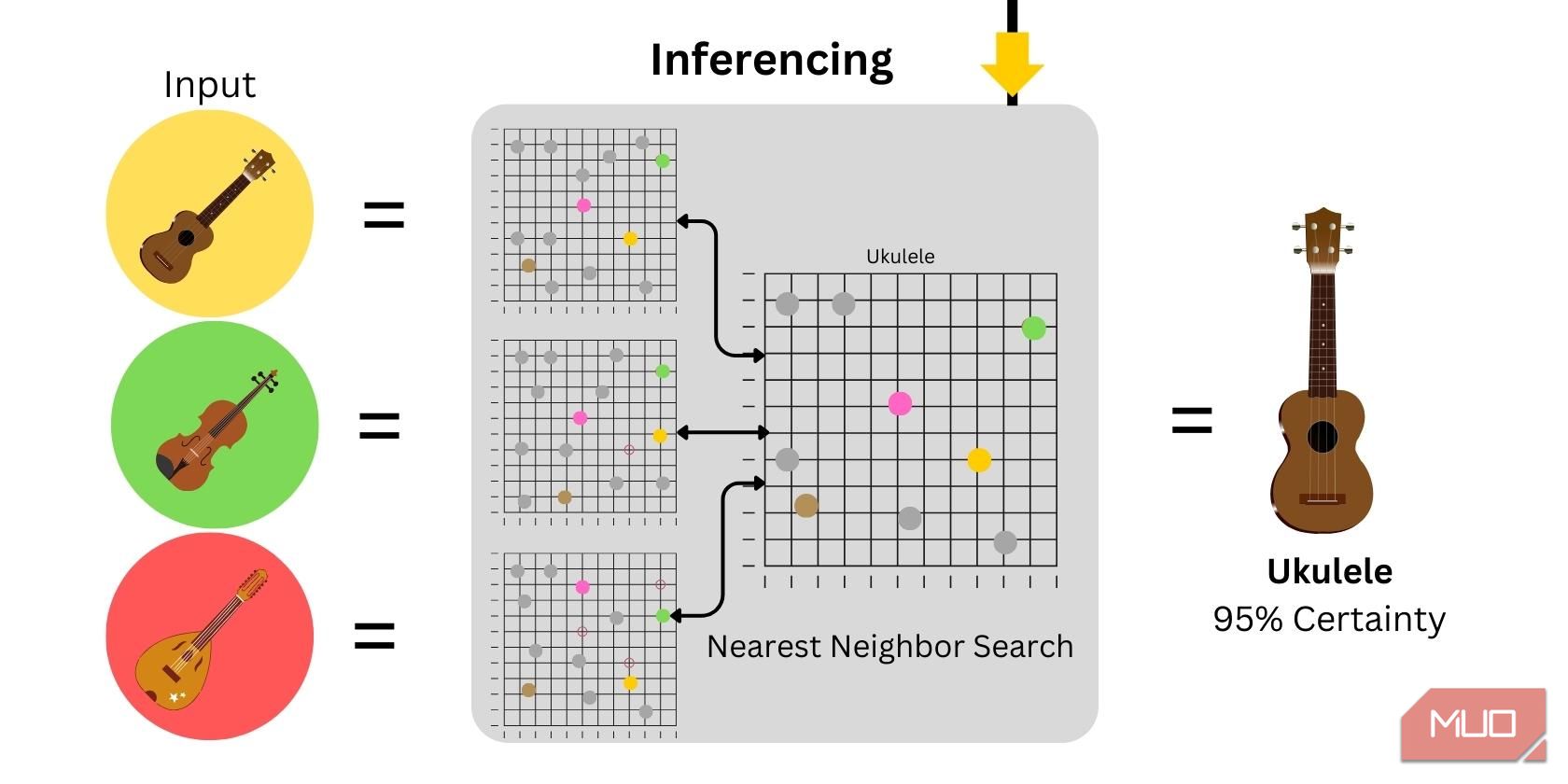

3. Slutledning

Inferencing är användningen av modellen för att generera förutsägelser eller utdata. Vid nollbildsklassificering genereras ordinbäddningar på den givna bildinmatningen och plottas sedan och jämförs med hjälpdata. Säkerhetsnivån kommer att bero på likheten mellan indata och hjälpdata som tillhandahålls.

Hur Zero-Shot Learning förbättrar AI

Zero-shot learning förbättrar AI-modeller genom att ta itu med flera utmaningar inom maskininlärning, inklusive:

- Förbättrad generalisering: Genom att minska beroendet av märkta data kan modellerna tränas i större datamängder, vilket förbättrar generaliseringen och gör modellen mer robust och tillförlitlig. När modellerna blir mer erfarna och generaliserade kan det till och med vara möjligt för modeller att lära sig sunt förnuft snarare än det typiska sättet att analysera information.

- Skalbarhet: Modeller kan kontinuerligt tränas och få mer kunskap genom överföringslärande. Företag och oberoende forskare kan kontinuerligt förbättra sina modeller för att bli mer kapabla i framtiden.

- Minskad risk för överanpassning: Överanpassning kan hända på grund av att modellen tränas på en liten datamängd som inte innehåller tillräckligt med variation för att representera alla möjliga indata. Att träna modellen genom noll-shot-inlärning minskar chanserna att överanpassa sig genom att träna modellen för att få en bättre kontextuell förståelse av ämnen.

- Kostnadseffektivt: Att tillhandahålla en stor mängd märkt data kan ta tid och resurser. Genom att använda noll-shot transfer learning kan träning av en robust modell göras med mycket mindre tid och märkta data.

När AI utvecklas kommer tekniker som noll-shot-inlärning att bli ännu viktigare.

Framtiden för Zero-Shot Learning

Zero-shot learning har blivit en viktig del av maskininlärning. Det gör det möjligt för modeller att känna igen och klassificera nya klasser utan explicit utbildning. Med pågående framsteg inom modellarkitekturer, attributbaserade tillvägagångssätt och multimodal integration, kan noll-shot-inlärning avsevärt bidra till att göra modeller mycket mer anpassningsbara för att hantera komplexa utmaningar inom robotik, sjukvård och datorseende.