Förklarbar artificiell intelligens (XAI) är ett begrepp som växer i betydelse, och företag efterfrågar det alltmer. Detta beror på att XAI hjälper dem att förstå och tolka modeller för artificiell intelligens och maskininlärning.

I vår nutida värld, som i stor utsträckning styrs av data, intar AI en central position.

Många typer av AI-lösningar används inom olika branscher för att öka tillväxten och effektivisera verksamheten.

XAI hjälper också till att skapa förståelse för hur AI-modellerna fungerar och hur de genererar resultat.

Om du fortfarande undrar varför XAI är relevant för dig, då är den här artikeln precis rätt.

Låt oss sätta igång!

Vad är förklarbar AI?

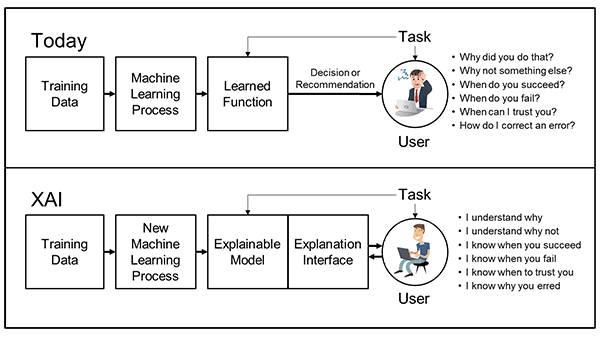

Förklarbar AI (XAI) är en samling metoder och processer som syftar till att hjälpa användare att förstå och lita på de resultat och slutsatser som AI-modeller genererar. I grunden ger XAI användare insikt i hur en komplex algoritm för maskininlärning fungerar och vilken logik som styr beslutsfattandet i dessa modeller.

Genom sitt ramverk och sina verktyg underlättar XAI för utvecklare och organisationer att införa transparens i en AI-modell. Detta gör att användarna kan förstå resonemanget bakom en förutsägelse. Det är särskilt fördelaktigt i organisationer där AI används på olika sätt, eftersom det bidrar till att förbättra AI:s precision, effektivitet och öppenhet.

Dessutom kan XAI belysa eventuella fördomar och problem som kan uppstå när komplexa ML-algoritmer hanterar specifika resultat. En ”svart låda”-modell, som är resultatet av en komplex ML-algoritm, kan vara nästan omöjlig att förstå, även för de datavetare som skapar algoritmen.

Den transparens som XAI bidrar med är därför värdefull för organisationer. Den hjälper dem att förstå hur man på bästa sätt kan utnyttja AI och fatta välgrundade beslut. Förklaringarna som XAI ger presenteras ofta i form av texter eller bilder, vilket ger insikt i hur AI-modellerna fungerar internt.

För att förtydliga den extra metadatainformationen om AI-modellen använder XAI också andra förklaringsmekanismer, som funktionsrelevans, förenklade förklaringar och förklaringar genom exempel.

Efterfrågan på XAI ökar snabbt i takt med att fler och fler organisationer implementerar tekniken i sina system. I takt med att XAI utvecklas förbättras också de metoder och processer som används för att skapa förklaringar.

Varför är XAI viktigt?

I dagens läge använder många organisationer AI-modeller i sin verksamhet och låter AI:s förutsägelser styra deras framtida beslut. Detta är dock inte alltid helt korrekt, och många AI-modeller lider av fördomar.

Dessa fördomar kan bero på olika faktorer och kan påverka AI-modellernas beslut. Ett särskilt problem är att AI:s beslutsförmåga ofta försämras när modellen matas med produktionsdata som skiljer sig från träningsdata.

Vidare kan maskininlärningsmodeller och neurala nätverk vara svåra att tolka, och det kan ofta vara omöjligt för datavetare att fullt ut förstå dem. Om man litar fullständigt på AI-modellernas beslut, kan det orsaka oönskade problem och hindra den övergripande tillväxten.

Därför är det viktigt för organisationer att ha en fullständig förståelse för hur AI:s beslutsprocesser fungerar och den logik som ligger bakom de resultat som AI-modellerna presenterar. Det är här XAI kommer in i bilden som ett användbart verktyg. Det ger organisationer tydliga förklaringar av AI-modellernas beslutsfattande, inklusive den logik som används.

XAI hjälper dig att övervaka allt från maskininlärningsalgoritmer till att utvärdera neurala nätverk och djupinlärningsnätverk. Du får korrekta förklaringar för varje beslut. Med XAI blir det enklare att bedöma hur korrekta och ansvarsfulla AI-besluten är, och du kan ta reda på om de är lämpliga för din organisation.

XAI är en viktig komponent för att implementera och underhålla ansvarsfulla AI-modeller som fattar rättvisa och korrekta beslut. XAI bidrar även till att upprätthålla förtroendet hos slutanvändarna, samtidigt som säkerhets- och efterlevnadsrisker minimeras.

Hur fungerar XAI?

Modern AI-teknik som används i företag genererar resultat eller fattar beslut genom att använda olika modeller. Dessa AI-tekniker förklarar dock inte hur resultatet har uppnåtts eller logiken bakom besluten.

För att överbrygga denna lucka implementerar företag nu XAI. XAI använder en förklarbar modell och all metadata med ett förklaringsgränssnitt för att underlätta förståelsen av hur AI-modellen fungerar.

När AI-teknik införlivas i affärssystem introduceras AI-metoder på olika nivåer. Dessa AI-metoder omfattar maskininlärning (ML), maskinresonemang (MR) och integration mellan MR och ML.

De komponenter som XAI introducerar i en befintlig AI-modell är förklaringar, dataförklaringar, MR-förklarbarhet och ML-förklarbarhet. Dessutom bidrar XAI till tolkbarhet och förklarbarhet mellan MR och ML.

Arbetet med XAI kan delas in i tre kategorier:

- Förklarlig data: Detta belyser vilken typ av data och vilket innehåll som används för att träna AI-modellen. Dessutom klargörs skälen bakom valen, hur urvalet har gjorts och eventuella insatser som krävs för att eliminera fördomar.

- Förklarliga förutsägelser: XAI visar alla de funktioner som AI-modellen har använt för att generera resultatet.

- Förklarliga algoritmer: Här beskrivs alla lager i AI-modellen, och hur varje lager bidrar till slutresultatet förklaras.

Förklarliga förutsägelser och algoritmer är dock fortfarande under utveckling. För närvarande kan endast förklarlig data användas för att förklara neurala nätverk.

XAI använder två metoder för att förklara beslutsprocessen:

- Proxymodellering: Här används en approximativ modell, som skiljer sig från originalet. Detta leder till ett ungefärligt resultat som kan skilja sig från det faktiska resultatet.

- Design för tolkning: Detta är en populär metod där XAI utvecklar en modell som är lätt att förstå för mänskliga användare. Dessa modeller är dock inte lika precisa eller kraftfulla som faktiska AI-modeller.

Fördelarna med XAI

Förklarbar AI, eller XAI, har stor betydelse för utvecklingen inom AI-området. Den hjälper människor att förstå hur en AI fungerar och medför många fördelar, som till exempel:

Ökad transparens och tillit

Företag som implementerar AI-modeller i sina system kan få insikt i hur komplexa AI-modeller fungerar och varför de producerar specifika resultat under olika förutsättningar.

XAI är också värdefullt för företag som vill förstå orsaken till resultaten från så kallade ”svarta lådor”-modeller. Detta ökar transparensen och förtroendet mellan mänskliga användare och maskiner.

Förbättrad användning av AI-modeller

När organisationer förstår hur AI-modeller fungerar och inser deras fördelar, kommer användningen av AI-modeller att öka. Förtroendet för AI-beslut kommer också att stärkas tack vare korrekta förklaringar.

Ökad produktivitet

Genom att införa XAI i AI-system kan ML-driftsteam enkelt identifiera fel och områden som behöver förbättras i det befintliga systemet. XAI hjälper också ML-driftsteam att säkerställa en smidig och effektiv AI-drift.

Detta leder till en avsevärd produktivitetsökning, eftersom ML-driftsteamet får insikt i logiken som styr AI-modellens resultat.

Minskade risker och kostnader

XAI spelar en viktig roll i att minska kostnaderna för hantering av AI-modeller. Genom att förklara alla resultat och riskområden minimeras behovet av manuell inspektion, liksom risken för kostsamma misstag som kan skada relationerna med slutanvändarna.

Upptäckt av nya möjligheter

När det tekniska och affärsmässiga teamet får möjlighet att förstå AI:s beslutsprocesser, kan det leda till att de upptäcker nya möjligheter. Genom att granska specifika resultat mer ingående kan de komma fram till nya insikter som inte var uppenbara från början.

Utmaningarna med XAI

Några vanliga utmaningar för XAI är:

- Svårigheter att tolka: Det finns många ML-system som är svåra att tolka, vilket gör att förklaringarna från XAI kan vara svåra för användarna att förstå. En oförklarlig ”svart låda”-strategi kan orsaka allvarliga operativa och etiska problem.

- Rättvisa: Det är svårt för XAI att avgöra om ett visst AI-beslut är rättvist eller inte. Rättvisa är en subjektiv fråga som är beroende av de data som AI-modellen har tränats på.

- Säkerhet: En betydande säkerhetsrisk med XAI är att klienter kan manipulera ML-modellens beslutsprocess och påverka resultatet till sin egen fördel. Det enda som teknisk personal kan göra är att återställa den datauppsättning som används för att träna algoritmen.

Skillnaden mellan XAI och AI

Även om XAI och AI är relaterade finns det några grundläggande skillnader mellan dem.

| Förklarbar AI (XAI) | Artificiell intelligens (AI) |

| XAI förklarar eller visar logiken bakom en komplex ML-modells beslutsfattande. | Artificiell intelligens tillhandahåller endast bedömningen eller resultatet av ett beslut som fattats av en ML-modell. |

| XAI ger en korrekt förklaring och ökar användarnas tilltro till AI-modellen. | Med AI får man endast ett domslut, vilket kan lämna användare osäkra på hur AI:n har kommit fram till sin slutsats. Detta kan minska förtroendet för besluten. |

| XAI minskar de fördomar som är vanliga i många AI-modeller. | AI fattar ofta beslut baserat på fördomar som finns i världen. |

| XAI minskar kostnaderna för fel som görs av AI-system. | AI-modeller är inte helt korrekta och kan göra felaktiga förutsägelser. Ett felaktigt beslut kan leda till förluster i ett företag. |

| XAI är fortfarande under utveckling, särskilt när det gäller att förklara komplexa ”svarta lådor”. | AI har utvecklats snabbt och kan snabbt lösa många problem utan större svårigheter. |

| Eftersom XAI förklarar all logik och alla beslutsprocesser i en AI-modell, kan vem som helst enkelt manipulera processen för felaktiga ändamål. | AI-modeller anger inte orsaken eller logiken bakom deras slutliga förutsägelse, vilket gör det svårt för någon att påverka deras beslut. |

XAI:s inverkan på olika sektorer

Ankomsten av XAI har haft stor inverkan inom olika sektorer där AI spelar en viktig roll i beslutsfattandet. Låt oss ta en titt på några av dem.

#1. Finans

AI-baserade lösningar dominerar finanssektorn och de flesta företag använder dem för olika uppgifter. Finanssektorn är dock hårt reglerad och kräver noggrann revision innan ett ekonomiskt beslut fattas.

XAI kan underlätta i detta avseende och presentera motiveringar till ekonomiska beslut. Detta är avgörande för att upprätthålla slutanvändarnas förtroende, eftersom de får en förklaring till de ekonomiska beslut som organisationen fattar.

#2. Sjukvård

Införandet av XAI har varit till nytta för sjukvården på en mängd olika sätt. XAI kan hjälpa till att upptäcka och diagnostisera sjukdomar, samt identifiera deras grundorsak. Detta kan hjälpa läkare att sätta in rätt behandling.

#3. Tillverkning

AI-modeller används i allt större utsträckning i tillverkningssektorn för applikationer som hantering, reparation, logistik med mera. Dessa AI-modeller är dock inte alltid konsekventa, vilket kan leda till problem med förtroendet.

XAI har löst många av dessa problem, eftersom det kan erbjuda den bästa möjliga lösningen för många tillämpningar inom tillverkningssektorn, samt en tillhörande förklaring. XAI visar logiken och skälet bakom ett visst beslut som fattas för arbetare, vilket i sin tur bidrar till att bygga upp förtroende.

#4. Fordon

Integreringen av XAI i självkörande bilar är nödvändig, eftersom det gör att fordonet kan motivera varje beslut det fattar i händelse av en olycka. Genom att lära av olika situationer och olyckor hjälper XAI autonoma bilar att fatta beslut och förbättra säkerheten för både passagerare och fotgängare.

Lärresurser

Här är några böcker och kurser som du kan överväga om du vill lära dig mer om XAI:

#1. Förklarbar AI med Python

Kursen ”Explainable AI with Python” på Udemy är utformad av Parteek Bhatia. Den hjälper dig att lära dig olika aspekter av XAI, inklusive applikationer, olika XAI-tekniker och Googles ”What-if”-verktyg. Du får också en kategorisering av XAI:s olika aspekter.

#2. Machine Learning Modeling Pipelines

Om du vill lära dig förklarbar AI och få kunskap om hur du implementerar verktyg och tekniker för att hantera modelleringsresurser är ”Machine Learning Modeling Pipeline” från Coursera ett bra val.

Detta är en av de bästa kurserna med många bra recensioner och den undervisas av en välkänd instruktör, Robert Crowe. Du får också många timmars undervisning om modellanalys och tolkbarhet.

#3. Förklarbar artificiell intelligens

”Explainable Artificial Intelligence”, skriven av Uday Kamath och John Liu, är en utmärkt bok för att lära sig om tolkbarhet inom maskininlärning.

Du hittar många fallstudier och tillhörande material som hjälper dig att lära dig XAI. Författarna ger många praktiska exempel som gör XAI lättare att förstå.

#4. Hands-On Explainable AI (XAI) med Python

”Hands-on Explainable AI (XAI) with Python” är en välkänd bok skriven av Denis Rothman.

Den ger en detaljerad genomgång av XAI-verktyg och -tekniker för att förstå AI-resultat, vilket är viktigt för moderna företag. Du kommer också att lära dig att hantera och undvika olika problem som relaterar till fördomar inom AI.

Slutsats

Förklarbar AI är ett effektivt koncept som gör det lättare för företagsägare, dataanalytiker och ingenjörer att förstå beslutsprocessen hos AI-modeller. XAI kan tolka komplexa ML-modeller som till och med kan vara omöjliga att dechiffrera för datavetare.

Även om XAI utvecklas med tiden, finns det fortfarande områden som behöver förbättras. Jag hoppas att den här artikeln har gett dig en bättre förståelse för XAI, hur det fungerar, dess fördelar och utmaningar, samt hur det används inom olika sektorer. Du kan också läsa de rekommenderade kurserna och böckerna för att få fler insikter i XAI.

Du kan även läsa om Artificiell smal intelligens (ANI).