Hur ofta vänder du dig till chatbots eller AI-drivna system för att slutföra uppgifter eller få svar på dina funderingar?

Om ditt svar är ”ofta!” eller ”ständigt!”, finns det skäl till oro 😟.

Oavsett om du är en student som flitigt använder AI för att underlätta din research, eller en programmerare som förlitar sig på AI för att generera kod, är risken för fel i det AI-genererade materialet ganska stor – främst på grund av inkonsekvenser och brister i den data som AI:n tränats på.

Även om AI och maskininlärning (ML) förändrar världen genom att automatisera repetitiva uppgifter och lösa komplexa problem, finns det fortfarande utmaningar när det gäller att generera exakta resultat baserat på de förfrågningar som ställs.

Om du använder innehållsgeneratorer och chatbots ofta, kommer du snart att märka att de ger felaktiga, irrelevanta eller rent påhittade svar. Dessa kallas AI-hallucinationer eller konfabulationer, och de utgör ett betydande problem för de som förlitar sig på AI.

Oavsett om du stött på AI-hallucinationer eller vill veta mer, utforskar denna artikel ämnet på djupet. Vi kommer att definiera AI-hallucination, förklara orsakerna bakom det, ge exempel och diskutera om det kan åtgärdas.

Låt oss börja!

Vad är en AI-hallucination?

En AI-hallucination uppstår när en AI-modell eller stor språkmodell (LLM) genererar falsk, felaktig eller ologisk information. AI:n ger ett självsäkert svar som inte stämmer överens med eller är grundat i dess träningsdata, och presenterar detta som fakta trots att det saknar logisk koppling!

Och vi brukar säga att ”att fela är mänskligt”!😅

AI-verktyg, som ChatGPT, tränas vanligtvis för att förutsäga ord som bäst matchar en fråga. Även om dessa ofta ger korrekta svar, kan den underliggande algoritmen ibland sakna logiskt resonemang, vilket leder till att chatbotar ger motstridiga uppgifter och felaktiga påståenden.

Med andra ord, AI-modeller ”hallucinerar” ibland för att försöka tillfredsställa användaren, istället för att vara objektiva, specifika eller exakta.

AI-hallucinationer kan variera från mindre inkonsekvenser till fullständigt falska svar. Här är olika typer av AI-hallucinationer som du kan stöta på:

#1. Självmotsägelse: Detta inträffar när en LLM-modell ger en mening som motsäger en tidigare formulering.

#2. Faktamotsägelse: Denna typ uppstår när en AI-modell presenterar falsk eller fiktiv information som ett faktum.

#3. Promptmotsägelse: Denna typ av hallucination uppstår när resultatet motsäger själva frågan den ska besvara. Till exempel, om frågan är: ”Skriv en inbjudan till mina vänner till min födelsedagsfest,” kan modellen svara: ”Grattis på årsdagen, mamma och pappa.”

#4. Slumpmässiga eller irrelevanta hallucinationer: Detta inträffar när modellen genererar ett helt irrelevant svar på den givna frågan. Exempelvis, om frågan är: ”Vad är speciellt med New York?”, kan du få ett svar som: ”New York är en av de mest befolkade städerna i Amerika. Hundar är de mest lojala djuren och människans bästa vän.”

Läs också: Hur generativ AI-sökning förändrar sökmotorer

Exempel på AI-hallucinationer

Det finns många anmärkningsvärda exempel på AI-hallucinationer. Här är några av de mest kända:

- Googles chatbot, Bard, hävdade felaktigt att James Webb-teleskopet tog de första bilderna av en exoplanet, en planet utanför vårt solsystem.

- Metas Galactica LLM-demo från 2022, avsedd för studenter och forskare, gav felaktig information och ett falskt dokument när den ombads att skriva om att skapa avatarer.

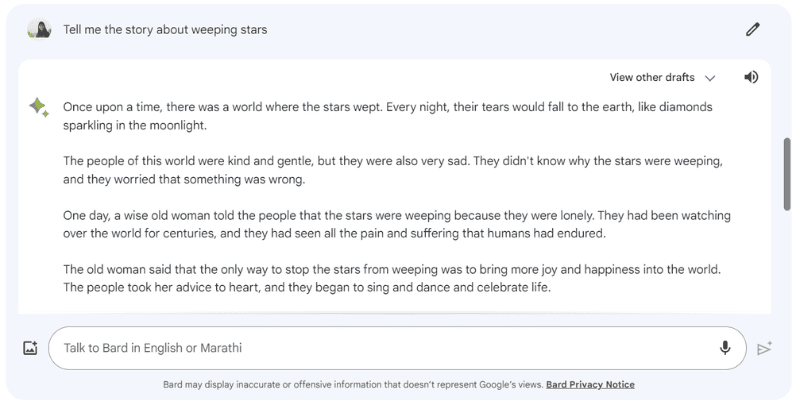

Här är ett exempel på hur Google Bard hallucinerade när jag ställde frågan: ”Berätta historien om de gråtande stjärnorna,” som inte existerar.

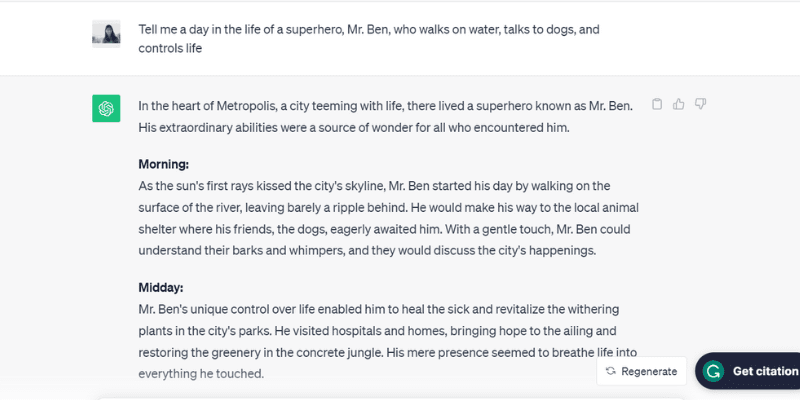

Här är ett annat exempel där ChatGPT (GPT-3.5) hallucinerade genom att prata om en fiktiv person, Mr. Ben, när jag frågade: ”Berätta om en dag i livet för superhjälten Mr. Ben, som går på vatten, pratar med hundar och styr livet.”

ChatGPT skapade en hel dag för Mr. Ben, som inte existerar, genom att svara på frågan, vilket är en av de främsta orsakerna bakom AI-hallucinationer.

Det verkar som om den var överentusiastisk att behaga!

Men varför uppstår dessa hallucinationer? Låt oss undersöka några av de vanligaste orsakerna.

Varför inträffar AI-hallucinationer?

Det finns flera tekniska och andra orsaker bakom AI-hallucinationer. Här är några av de vanligaste:

- Dålig kvalitet, otillräcklig eller inaktuell data: LLM:er och AI-modeller är starkt beroende av träningsdata. De är inte bättre än den information de har tränats på. Om AI-verktyget har fel, inkonsekvenser, fördomar eller ineffektivitet i sin träningsdata, eller helt enkelt inte förstår den ställda frågan, kommer det att generera AI-hallucinationer, eftersom verktyget skapar svar från en begränsad datamängd.

- Överanpassning: Eftersom AI-modellen tränas på en begränsad data, kan den försöka memorera frågor och lämpliga svar istället för att effektivt generera eller generalisera ny data, vilket leder till AI-hallucinationer.

- Kontext i inmatningen: AI-hallucinationer kan också uppstå på grund av otydliga, felaktiga, inkonsekventa eller motsägelsefulla frågor. Användarna kontrollerar inmatningen, inte AI-modellens träningsdata. Därför är det viktigt att ge tydliga frågor för att undvika AI-hallucinationer.

- Användning av idiom eller slang: Om frågan innehåller idiom eller slang, ökar risken för AI-hallucinationer, särskilt om modellen inte har tränats på sådana uttryck.

- Avsiktliga attacker: Ibland kan angripare medvetet formulera frågor som är avsedda att förvirra AI-modeller, korrumpera deras träningsdata och därmed skapa AI-hallucinationer.

Negativa konsekvenser av AI-hallucinationer

AI-hallucinationer är stora etiska problem med betydande konsekvenser för individer och organisationer. Här är några av de främsta anledningarna till att AI-hallucinationer är ett stort problem:

- Spridning av desinformation: AI-hallucinationer, som beror på felaktiga frågor eller inkonsekvenser i träningsdata, kan leda till massiv spridning av desinformation, vilket påverkar en stor mängd individer, organisationer och myndigheter.

- Minskat förtroende: När felaktig information från AI sprids på internet och framstår som auktoritativ, minskar det användarnas förtroende för informationen på internet.

- Risk för användare: Förutom etiska problem och att vilseleda individer, kan AI-hallucinationer även skada människor genom att sprida felaktig information om allvarliga ämnen, som sjukdomar och deras behandlingar, eller enkla råd om att skilja mellan giftiga och ätbara svampar. Även mindre fel kan äventyra människors liv.

Bästa metoder för att upptäcka och förhindra AI-hallucinationer

Med tanke på de negativa konsekvenserna av AI-hallucinationer, är det viktigt att förhindra dem. De företag som äger dessa AI-modeller arbetar intensivt för att minska AI-hallucinationer, men vi användare måste också vara försiktiga.

Baserat på forskning, erfarenhet och testning, har jag sammanställt några strategier för att upptäcka och förhindra AI-hallucinationer när du använder en chatbot eller interagerar med en LLM:

#1. Använd representativ och mångsidig träningsdata

Som användare bör du använda LLM:er med en mångsidig träningsdata som representerar den verkliga världen för att minska risken för partiska, felaktiga eller påhittade svar.

Företag bör regelbundet uppdatera och utöka AI-modellens träningsdata för att ta hänsyn till nya kulturella, politiska och andra utvecklingar.

#2. Begränsa resultaten eller svaren

Du kan begränsa antalet potentiella svar som ett AI-verktyg kan generera genom att ställa specifika frågor om vilken typ av svar du vill ha.

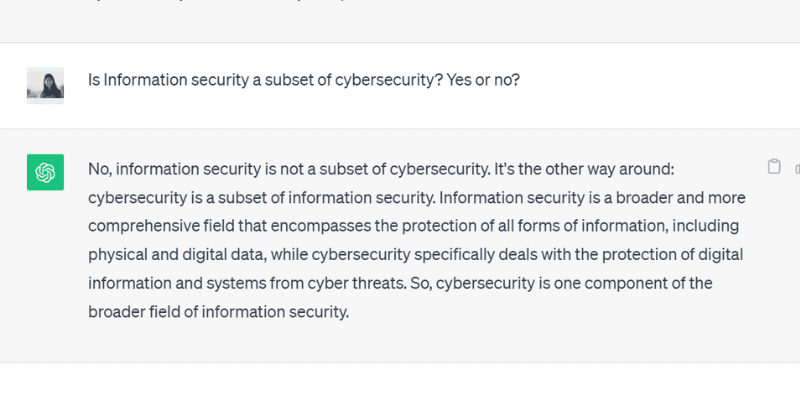

Du kan till exempel ställa en fråga som endast kan besvaras med ja eller nej. Du kan också ge flera alternativ för verktyget att välja mellan, vilket begränsar dess möjlighet att ge ett orelaterat svar.

När jag ställde en ja/nej-fråga till ChatGPT GPT 3.5, fick jag exakt det här svaret:

#3. Förse modellen med relevant data

Du kan inte förvänta dig att en person ska kunna svara på en fråga utan förkunskaper eller sammanhang. På samma sätt fungerar AI-modeller bäst när de har tillgång till relevant data.

Att förse en AI-modell med relevant branschspecifik data ger den ytterligare kontext och information. Detta extra sammanhang hjälper AI-modellen att bättre förstå frågor, vilket gör det möjligt för den att generera korrekta, rimliga och kontextuella svar i stället för hallucinationer.

#4. Skapa datamallar för AI-modellen att följa

Genom att tillhandahålla en datamall eller ett exempel på en specifik formel eller beräkning i ett fördefinierat format, kan du hjälpa AI-modellen att generera korrekta svar, i linje med de givna riktlinjerna.

Genom att förlita sig på datamallar kan man minska risken för AI-hallucinationer och säkerställa konsekvens och noggrannhet i svaren. Att ge en referensmodell i form av en tabell kan alltså vägleda AI-modellen i beräkningar och eliminera risken för hallucinationer.

#5. Var specifik i din fråga genom att tilldela modellen en viss roll

Att tilldela specifika roller till AI-modellen är ett effektivt sätt att förhindra hallucinationer. Du kan till exempel använda frågor som: ”Du är en erfaren gitarrspelare” eller ”Du är en begåvad matematiker,” följt av din specifika fråga.

Genom att tilldela roller, kan du styra modellen till att ge det svar du vill ha istället för ett påhittat svar.

Och oroa dig inte. Du kan fortfarande ha roligt med AI (även med hallucinationerna). Kolla in hur du kan skapa viral AI-spiral-konst själv!

#6. Testa det med temperatur

Temperaturen spelar en viktig roll för huruvida en AI-modell ger hallucinationer eller kreativa svar.

En lägre temperatur innebär att modellen genererar deterministiska eller förutsägbara resultat, medan en högre temperatur ökar risken för slumpmässiga svar och hallucinationer.

Många AI-företag har en ”Temperatur”-reglage så att användare kan justera inställningarna efter sina behov.

Företag kan också ställa in en standardtemperatur för att verktyget ska ge rimliga svar och hitta en balans mellan noggrannhet och kreativitet.

#7. Verifiera alltid

Slutligen är det inte klokt att lita blint på AI-genererade svar utan att kontrollera dem.

Samtidigt som AI-företag och forskare arbetar med att minska hallucinationer, måste användare alltid verifiera svaren från AI-modeller innan man använder eller tror på dem.

Så förutom de metoder som nämnts ovan, så som att formulera specifika frågor och lägga till exempel för att vägleda AI, bör du alltid kontrollera resultaten som AI-modellen genererar.

Kan AI-hallucinationer åtgärdas helt? En experts åsikt

Även om AI-hallucinationer påverkas av frågorna vi ställer, kan modellen ibland generera svar med sådan säkerhet att det är svårt att avgöra vad som är sant och vad som är falskt.

Så, är det möjligt att helt fixa eller förhindra AI-hallucinationer?

När frågan ställdes till Suresh Venkatasubramanian, professor vid Brown University, svarade han att frågan om AI-hallucinationer kan förhindras är ett ”aktivt forskningsområde.”

Han förklarade att detta beror på dessa AI-modellers natur, deras komplexitet och hur känsliga de är. En liten ändring i frågan kan göra stor skillnad i svaret.

Medan Venkatasubramanian ser lösningen av AI-hallucinationer som en forskningsfråga, tror Jevin West, professor vid University of Washington, att AI-hallucinationer aldrig kommer att försvinna.

West anser att det är omöjligt att eliminera hallucinationer helt från AI-bots eller chatbots, och att de därför alltid kommer att vara en inneboende egenskap hos AI.

Sundar Pichai, VD för Google, sa i en intervju med CBS att alla som använder AI stöter på hallucinationer, och att ingen i branschen ännu har löst detta problem. Han hävdade och försäkrade att AI-fältet snart kommer att utvecklas när det gäller att lösa AI-hallucinationer.

Samtidigt besökte Sam Altman, VD för OpenAI (ChatGPT), Indraprastha Institute of Information Technology i Delhi, där han påpekade att AI-hallucinationsproblemet borde vara betydligt mindre om ett och ett halvt till två år.

Han tillade också att modellen måste lära sig skillnaden mellan noggrannhet och kreativitet och veta när man ska använda det ena eller det andra.

Slutsats

AI-hallucinationer har fått stor uppmärksamhet de senaste åren och är ett område som forskare och företag försöker lösa så snart som möjligt.

Även om AI har gjort stora framsteg, är den inte felfri, och problemet med AI-hallucinationer utgör stora utmaningar inom många sektorer, som hälsovården, innehållsproduktion och bilindustrin.

Samtidigt som forskarna gör sin del, har vi användare också ett ansvar att ställa specifika och tydliga frågor, lägga till exempel och ge datamallar för att få giltiga och rimliga svar, undvika att störa AI-modellens träningsdata och förhindra hallucinationer.

Om AI-hallucinationer kan botas är fortfarande en öppen fråga, men jag tror att det finns hopp, och vi kan fortsätta att använda AI-system på ett ansvarsfullt och säkert sätt till gagn för världen.

Läs mer om exempel på artificiell intelligens (AI) i vår vardag.