Webben är full av skadliga sidor. Tyvärr kan dessa också finnas på din klient/leverantörs webbplats.

Inget företag idag är utan någon integration som strömmar från eller ger input till en kunds eller leverantörs webbplats. Självklart kommer ditt företag inte att existera utan dessa tjänster, men ibland är det ett hot på grund av dessa tjänster. De externa webbplatserna du interagerar med kan ha skadligt innehåll (oavsett om det är installerat med avsikt eller äventyrat av en tredje part), och om det innehållet hittar sin väg till den förutbestämda platsen kan konsekvenserna bli katastrofala.

Kan vi inte skanna webbplatser efter skadliga sidor manuellt?

Det kan tyckas att en kompetent utvecklare borde kunna skanna sidor efter sårbarheter. Tyvärr är detta inte ens i närheten av verkligheten av många anledningar:

- Utvecklare är inte specialiserade på upptäckt/säkerhet. Deras expertis är att bygga komplex mjukvara genom att sätta ihop många mindre delsystem; med andra ord, de har helt enkelt inte kompetensen.

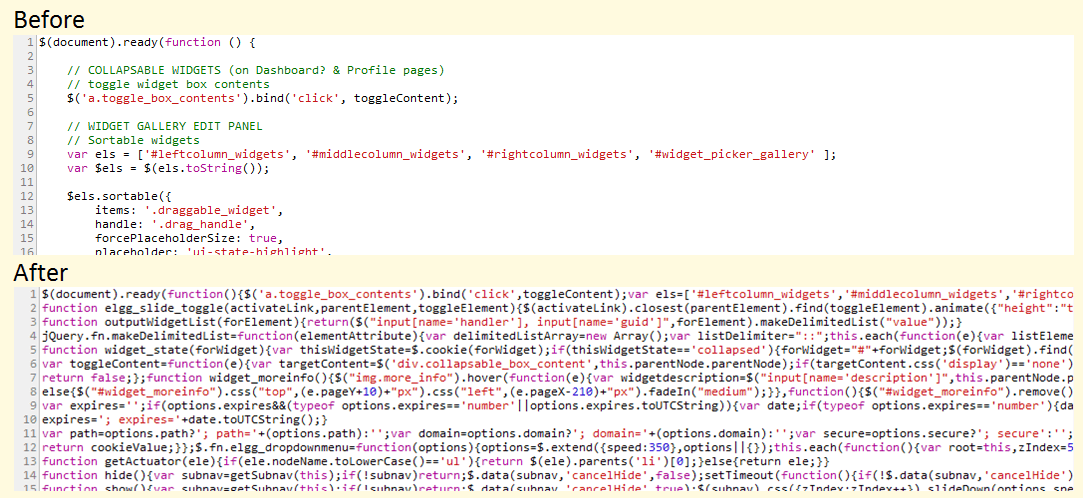

- Även om du skulle stöta på en utvecklare som är tillräckligt begåvad, skulle uppgiften helt enkelt bli för mycket. En typisk, funktionsrik webbsida innehåller tusentals rader kod – att sammanfoga dem alla för att ta fram den större bilden såväl som de små kryphålen är inget annat än en mardröm. Du kan lika gärna beordra någon att äta en hel elefant till lunch!

- För att minska sidladdningstider komprimerar och förminskar webbplatser ofta sina CSS- och JavaScript-filer. Detta resulterar i en sådan sopig röra av kod att det är helt omöjligt att läsa.

Vad tror du att den här koden gör? :kappa: (Källa elgg.org)

Vad tror du att den här koden gör? :kappa: (Källa elgg.org)

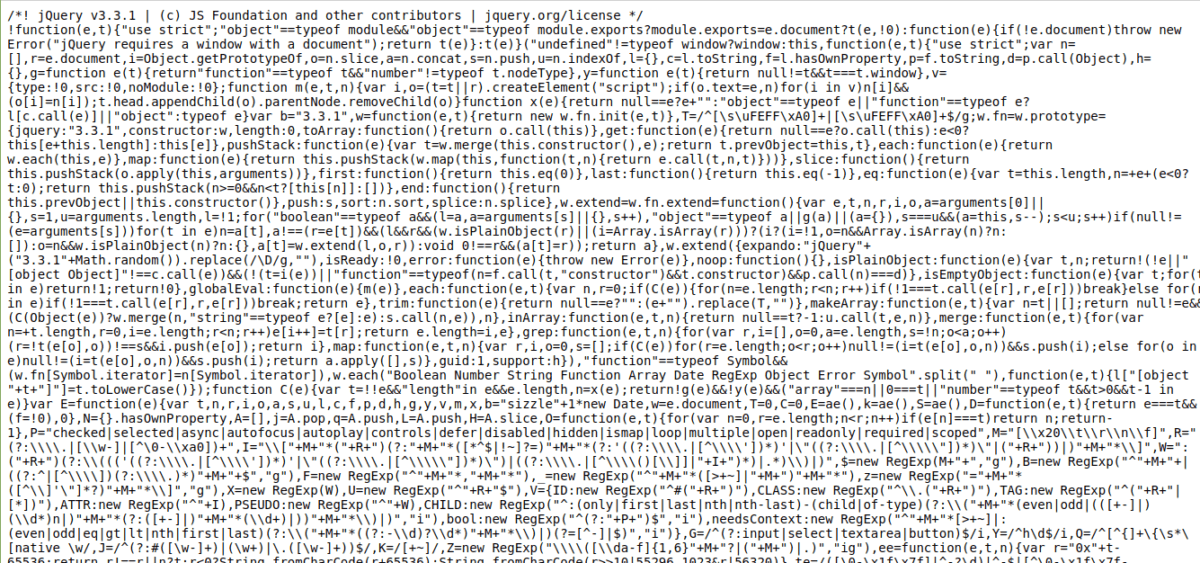

Om detta fortfarande ser läsvärt ut beror det på att de goda själarna där bestämde sig för att bevara variabelnamnen till ett stort sammanhang. Prova källkoden för jQuery, som någon kan vara värd på sin webbplats och manipulera med (två rader någonstans i den här röran):

För att inte tala om att källan är nära 5 000 rader kod. 😎

Det här är bara ett enda manus vi pratar om. En webbsida har vanligtvis 5-15 skript bifogade, och det är troligt att du arbetar med 10-20 webbsidor totalt. Tänk dig att behöva göra detta varje dag. . . Eller ännu värre, några gånger om dagen!

Tack och lov är det möjligt att skanna webbadresser snabbt och enkelt genom API:er. Du kan skanna inte bara webbsidor utan även filer som du får för nedladdning. Låt oss titta på några av API-verktygen som hjälper dig att göra detta. Och åh, eftersom det här är API:er, kommer din utvecklares ansträngningar att tjäna mycket bättre om du ber dem att bygga ett webbläsarverktyg med dessa API:er. 😀

Innehållsförteckning

Google webbrisk

Det är ingen överraskning att en webbsidagranskare kommer från företaget som praktiskt taget äger Internet (alla dess webbsidor, menar jag). Men det finns en hake: Google webbrisk är fortfarande i betaversion och är tillgänglig på begäran endast. Att vara i beta innebär fler brytande förändringar.

Ändå, med tanke på att API:et är ganska enkelt, kan alla ändringar hanteras av din utvecklare med hjälp av ett API-övervakningsverktyg och några minuters utvecklingstid. 🙂

Att använda API är också superlätt. För att kontrollera en enskild sida med hjälp av kommandoraden, skicka helt enkelt en begäran enligt följande:

curl -H "Content-Type: application/json" "https://webrisk.googleapis.com/v1beta1/uris:search?key=YOUR_API_KEY&threatTypes=MALWARE&uri=http%3A%2F%2Ftestsafebrowsing.appspot.com%2Fs%2Fmalware.html"

Om begäran lyckades, svarar API:et med typen av sårbarhet på sidan:

{

"threat": {

"threatTypes": [

"MALWARE"

],

"expireTime": "2019-07-17T15:01:23.045123456Z"

}

}

Som du kan se bekräftar API:et att sidan är känd för att innehålla skadlig programvara.

Observera att Google Web Risk API inte utför en diagnostik på begäran på en webbadress eller fil som du väljer. Den konsulterar en svartlista som underhålls av Google baserat på sökresultaten och rapporterna och rapporterar om webbadressen finns i den svarta listan eller inte. Med andra ord, om detta API säger att en URL är säker, är det säkert att anta att det är ganska säkert, men det finns inga garantier.

VirusTotal

VirusTotal är en annan cool tjänst som du kan använda för att skanna inte bara webbadresser, utan även enskilda filer (i den meningen sätter jag den över Google Web Risk när det gäller användbarhet). Om du är sugen på att testa tjänsten, gå bara till webbplatsen och direkt på startsidan finns det ett alternativ att komma igång.

Även om VirusTotal är tillgänglig som en gratis plattform byggd och kurerad av en livlig community, erbjuder den en kommersiell version av sitt API. Här är anledningen till att du vill betala för premiumtjänsten:

- Flexibel förfrågningsfrekvens och daglig kvot (i motsats till endast fyra förfrågningar per minut för det offentliga API)

- Den inskickade resursen skannas av VirusTotal av deras antivirus, och ytterligare diagnostisk information returneras.

- Beteendebaserad information om filer du skickar (filerna kommer att placeras i olika sandlådemiljöer för att övervaka misstänkta aktiviteter)

- Fråga i VirusTotal-fildatabasen efter olika parametrar (komplexa frågor stöds)

- Strikt SLA och svarstider (filer som skickas till VirusTotal via det offentliga API:et ställs i kö och tar avsevärd tid att analysera)

Om du väljer det privata VirusTotal API kan det vara en av de bästa investeringarna du någonsin gjort i en SaaS-produkt för ditt företag.

Scanii

En annan rekommendation för API:er för säkerhetsskanner är Scanii. Det är ett enkelt REST API som kan skanna inskickade dokument/filer för att se om det finns hot. Se det som en on-demand virusscanner som kan köras och skalas utan ansträngning!

Här är godsakerna som Scanii erbjuder:

- Kan upptäcka skadlig programvara, phishing-skript, skräppostinnehåll, NSFW-innehåll (Not Safe For Work), etc.

- Den är byggd på Amazon S3 för enkel skalning och noll-risk fillagring.

- Upptäck stötande, osäker eller potentiellt farlig text på över 23 språk.

- En enkel, utan krusiduller, fokuserad metod för API-baserad filskanning (med andra ord, inga onödigt ”hjälpsamma” funktioner)

Det riktigt bra är att Scanii är en metamotor; det vill säga, den utför inte skanningar på egen hand utan använder en uppsättning underliggande motorer som gör benarbetet. Det är en stor tillgång eftersom du inte behöver vara bunden till en viss säkerhetsmotor, vilket innebär att du inte behöver oroa dig för trasiga API-ändringar och annat.

Jag ser Scanii som en enorm välsignelse för plattformar som är beroende av användargenererat innehåll. Ett annat användningsfall är att skanna filer som genereras av en leverantörstjänst som du inte kan lita på till 100 %.

Metadefender

För vissa organisationer räcker det inte att skanna filer och webbsidor vid en enda slutpunkt. De har ett komplext informationsflöde och ingen av slutpunkterna kan äventyras. För dessa användningsfall, Metadefender är den idealiska lösningen.

Tänk på Metadefender som en paranoid gatekeeper som sitter mellan dina kärndatatillgångar och allt annat, inklusive nätverket. Jag säger ”paranoid” eftersom det är designfilosofin bakom Metadefender. Jag kan inte beskriva det här bättre än dem, så här kommer:

De flesta cybersäkerhetslösningar förlitar sig på detektion som sin kärnskyddsfunktion. MetaDefender-datasanering är inte beroende av upptäckt. Det förutsätter att alla filer kan vara infekterade och bygger om deras innehåll med en säker och effektiv process. Den stöder mer än 30 filtyper och skickar ut säkra och användbara filer. Datasanering är extremt effektiv för att förhindra riktade attacker, ransomware och andra typer av kända och okända skadliga hot.

Det finns några snygga funktioner som Metadefender erbjuder:

- Förebyggande av dataförlust: Enkelt uttryckt är detta möjligheten att åsidosätta och skydda känslig information som upptäcks i filinnehållet. Till exempel kommer ett PDF-kvitto med kreditkortsnumret synligt att fördunklas av Metadefender.

- Distribuera lokalt eller i molnet (beroende på hur paranoid du är!).

- Titta rakt igenom 30+ typer av arkiveringsformat (zip, tar, rar, etc.) och 4 500 filtypsförfalskningstrick.

- Multi-channel distributioner – säkra bara filer, eller gå med e-post, nätverk och inloggningskontroll.

- Anpassade arbetsflöden för att tillämpa olika typer av skanningspipelines baserat på anpassade regler.

Metadefender innehåller 30+ motorer men abstraherar bort dem snyggt, så att du aldrig behöver tänka på dem. Om du är ett medelstort till ett stort företag som helt enkelt inte har råd med säkerhetsmardrömmar, är Metadefender ett utmärkt alternativ.

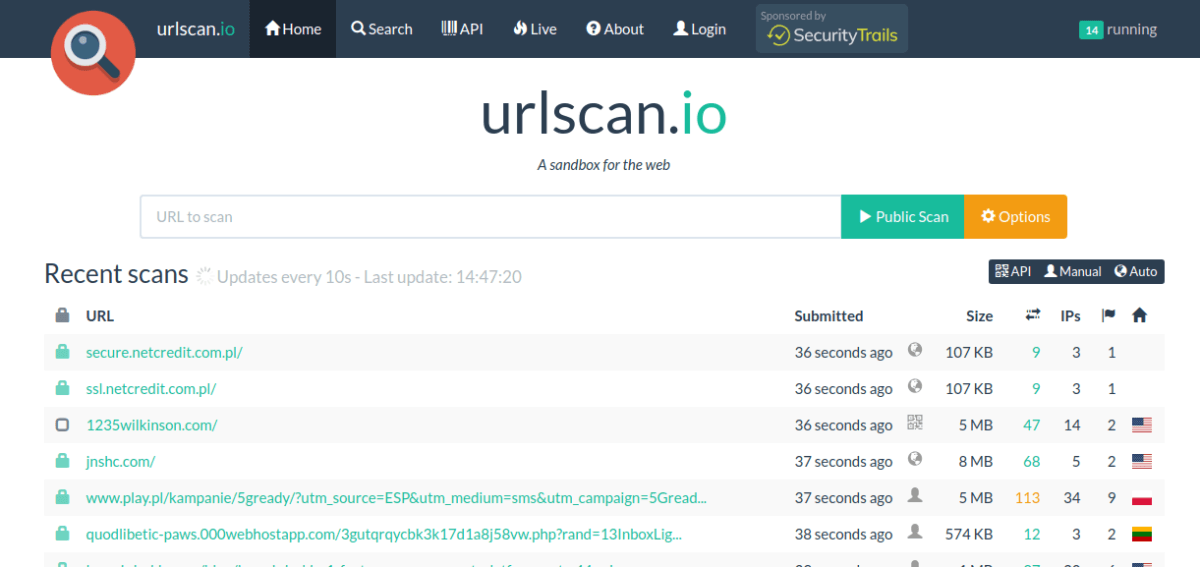

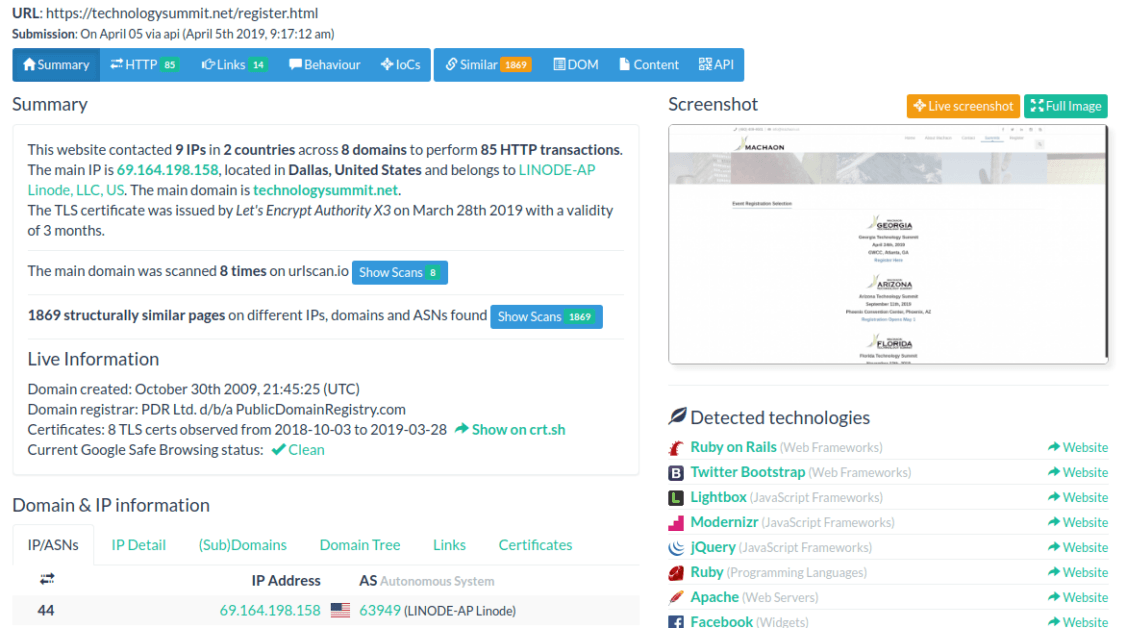

Urlscan.io

Om du mest sysslar med webbsidor och alltid har velat ha en mer djupgående titt på vad de gör bakom kulisserna, Urlscan.io är ett utmärkt vapen i din arsenal.

Mängden information Urlscan.io dumpar ut är inget mindre än imponerande. Du får bland annat se:

- Ett totalt antal IP-adresser som kontaktats av sidan.

- Lista över geografier och domäner sidan skickade information till.

- Teknik som används i front-end och backend av webbplatsen (inga påståenden om noggrannhet görs, men det är oroväckande korrekt!).

- Domän- och SSL-certifikatinformation

- Detaljerade HTTP-interaktioner tillsammans med nyttolast för begäran, servernamn, svarstider och mycket mer.

- Dolda omdirigeringar och misslyckade förfrågningar

- Utgående länkar

- JavaScript-analys (globala variabler som används i skripten, etc.)

- DOM-trädanalys, formulärinnehåll och mer.

Så här ser det hela ut:

API:et är enkelt och okomplicerat, vilket gör att du kan skicka in en URL för skanning, samt kontrollera skanningshistoriken för den URL:en (genomsökningar utförda av andra, det vill säga). Allt som allt, Urlscan.io tillhandahåller en mängd information för alla berörda företag eller individer.

SUCURI

SUCURI är en välkänd plattform när det kommer till onlineskanning av webbplatser efter hot och skadlig kod. Vad du kanske inte vet är att de har en REST API också, vilket gör att samma kraft kan utnyttjas programmatiskt.

Det finns inte mycket att prata om här, förutom att API:et är enkelt och fungerar bra. Självklart är Sucuri inte begränsat till ett skannings-API, så medan du håller på rekommenderar jag att du kollar in några av dess kraftfulla funktioner som skanning på serversidan (i grund och botten tillhandahåller du FTP-uppgifterna, och den loggar in och skannar alla filer efter hot!).

Quttera

Vår sista post i denna lista är Quttera, som erbjuder något lite annorlunda. Istället för att skanna domänen och inskickade sidor på begäran kan Quttera också utföra kontinuerlig övervakning, vilket hjälper dig att undvika nolldagssårbarheter.

REST API är enkelt och kraftfullt och kan returnera några fler format än JSON (exempelvis XML och YAML). Full multithreading och samtidighet stöds i skanningar, vilket gör att du kan köra flera uttömmande skanningar parallellt. Eftersom tjänsten körs i realtid är den ovärderlig för företag som är intresserade av verksamhetskritiska erbjudanden där driftstopp innebär undergång.

Slutsats

Säkerhetsverktyg som de som behandlas i den här artikeln är helt enkelt en extra försvarslinje (eller försiktighet, om du så vill). Precis som ett antivirusprogram finns det mycket dessa kan göra, men det finns inget sätt att de kan tillhandahålla en felsäker skanningsmetod. Det beror helt enkelt på att ett program som är skrivet med skadlig avsikt är detsamma för datorn som det som är skrivet för positiv effekt — de både frågar efter systemresurser och gör nätverksbegäranden; djävulen ligger i sammanhanget, vilket inte är för att datorer ska fungera framgångsrikt.

Som sagt, dessa API:er ger ett robust säkerhetsskydd som är önskvärt i de flesta fall – både för externa webbplatser och din egen! 🙂