I takt med att nya tekniker som djupinlärning, artificiell intelligens (AI) och maskininlärning (ML) vinner mark, ökar efterfrågan på molnbaserade GPU:er kraftigt.

För organisationer som arbetar med 3D-visualisering, maskininlärning, AI eller andra former av beräkningstunga uppgifter, är valet av GPU-beräkningslösning av avgörande betydelse.

Tidigare innebar träning av djupinlärningsmodeller och hantering av komplexa beräkningsuppgifter en betydande tidsåtgång och höga kostnader. Detta resulterade ofta i lagringsproblem, begränsat utrymme och minskad produktivitet.

Dagens moderna GPU:er är utvecklade för att adressera dessa utmaningar. De levererar hög effektivitet för tunga beräkningar och möjliggör snabbare träning av AI-modeller genom parallell bearbetning.

Enligt forskning från Indigo kan GPU:er erbjuda 250 gånger snabbare prestanda än CPU:er vid träning av neurala nätverk inom djupinlärning.

Med utvecklingen av molntjänster har moln-GPU:er introducerats. Dessa revolutionerar datavetenskap och andra framväxande tekniker genom att erbjuda ännu högre prestanda, förenklat underhåll, lägre kostnader, snabb skalbarhet och tidsbesparingar.

Den här artikeln ger en introduktion till moln-GPU-konceptet, dess relation till AI, ML, djupinlärning och presenterar några av de främsta moln-GPU-plattformarna för att driftsätta din föredragna GPU-lösning.

Låt oss sätta igång!

Vad är en moln-GPU?

För att förstå vad en moln-GPU är, behöver vi först se på vad GPU:er är generellt.

En Graphics Processing Unit (GPU) är en specialiserad elektronisk krets som används för att snabbt bearbeta och manipulera minnesinnehåll för att påskynda skapandet av bilder och grafik.

Moderna GPU:er är mer effektiva än CPU:er vid bildbehandling och datorgrafik på grund av deras parallella struktur. En GPU kan vara integrerad i moderkortet, placerad på ett grafikkort i en PC eller integrerad i CPU:n.

Moln-GPU:er är datorinstanser som använder kraftfull maskinvaruacceleration. Detta gör dem idealiska för att köra applikationer som hanterar stora AI- och djupinlärningsarbetsbelastningar i molnet. Det är alltså inte nödvändigt att installera en fysisk GPU på den egna enheten.

Några välkända tillverkare av grafikprocessorer är NVIDIA, AMD, Radeon och GeForce.

GPU:er används bland annat i:

- Mobiltelefoner

- Spelkonsoler

- Arbetsstationer

- Inbyggda system

- Persondatorer

Vad används GPU:er till?

Här är några exempel på användningsområden för GPU:er:

- Bildigenkänning inom AI och ML

- Beräkningar för 3D-datorgrafik och CAD-ritningar

- Texturmappning och rendering av polygoner

- Geometriska beräkningar, som transformationer och rotationer av hörn i koordinatsystem

- Programmerbara shaders för att bearbeta texturer och hörn

- GPU-accelererad videokodning, avkodning och streaming

- Grafikintensiva spel och molnbaserade spel

- Storskalig matematisk modellering, analys och djupinlärning som kräver parallell bearbetning

- Videoredigering, grafisk design och innehållsskapande

Vilka är fördelarna med moln-GPU:er? 👍

De viktigaste fördelarna med att använda moln-GPU:er inkluderar:

Hög skalbarhet

När en organisation växer, ökar också dess arbetsbelastning. En GPU-lösning som kan skalas i takt med ökningen är därför nödvändig. Moln-GPU:er möjliggör enkel expansion genom att du kan lägga till fler GPU:er utan komplexa procedurer. Omvänt är det också enkelt att skala ner vid behov.

Kostnadsminimering

Istället för att investera i kostsamma, fysiska grafikprocessorer, kan moln-GPU:er hyras per timme till en lägre kostnad. Du debiteras enbart för den tid du faktiskt använder resurserna, i motsats till fysiska enheter som medför höga kostnader även vid inaktivitet.

Frigör lokala resurser

Moln-GPU:er förbrukar inte lokala resurser, vilket fysiska GPU:er gör eftersom de tar upp en betydande del av datorns utrymme. Körning av storskaliga ML-modeller eller rendering av tunga uppgifter saktar också ner den lokala datorn.

Genom att flytta beräkningskraften till molnet, kan den lokala datorn användas enklare för att övervaka processen, utan att belastas av tunga arbetsbelastningar.

Tidsbesparing

Moln-GPU:er ger designers flexibilitet med snabb iteration och kortare renderingstider. Uppgifter som tidigare tog timmar eller dagar kan slutföras på några få minuter, vilket ökar teamets produktivitet avsevärt och frigör tid för innovation.

Hur hjälper GPU:er inom djupinlärning och AI?

Djupinlärning är grunden för artificiell intelligens. Det är en avancerad ML-teknik som använder artificiella neurala nätverk (ANN) för representativt lärande. Djupinlärningsmodeller hanterar stora datamängder och komplexa beräkningsprocesser.

Men hur passar GPU:er in i det här sammanhanget?

GPU:er är designade för att utföra parallella beräkningar – alltså hantera flera beräkningar samtidigt. De kan utnyttja djupinlärningsmodellernas kapacitet och accelerera omfattande beräkningsuppgifter.

GPU:er har många kärnor som erbjuder utmärkt parallell beräkningskapacitet och hög minnesbandbredd för att hantera stora datamängder inom djupinlärning. Därför är de ofta använda för att träna AI-modeller, rendera CAD-modeller och spela grafikintensiva datorspel.

Om man vill experimentera med flera algoritmer samtidigt, kan man köra dem separat på olika GPU:er, antingen över separata fysiska datorer eller inom en och samma. Detta möjliggör distribution av tunga datamodeller.

Hur du kommer igång med moln-GPU

Att börja med moln-GPU:er är inte komplicerat. Med en grundläggande förståelse av koncepten är det både enkelt och snabbt. Först och främst behöver du välja en moln-GPU-leverantör, till exempel Google Cloud Platform (GCP).

Därefter registrerar du dig hos GCP, och du får tillgång till standardfunktioner som molnfunktioner, lagringsalternativ, databashantering och integration med applikationer. Google Colaboratory, som fungerar som Jupyter Notebook, kan användas för att få tillgång till en GPU GRATIS. Sedan kan du påbörja rendering av GPU:er för ditt specifika ändamål.

Låt oss nu titta på olika alternativ för moln-GPU:er för att hantera AI och stora arbetsbelastningar.

Linode

Linode erbjuder on-demand GPU:er för parallell bearbetning av arbetsbelastningar som videobearbetning, vetenskapliga beräkningar, maskininlärning, AI och mycket mer. De levererar GPU-optimerade virtuella datorer som drivs av NVIDIA Quadro RTX 6000, Tensor och RT-kärnor samt CUDA-teknik för att hantera ray tracing, djupinlärning och komplexa beräkningsuppgifter.

Linode-GPU:er minskar kapitalutgifterna genom att erbjuda molnbaserad GPU-kraft. Därmed kan du fokusera på kärnverksamheten utan att oroa dig för hårdvaran.

Linodes GPU:er eliminerar hindren för att utnyttja dem för avancerade användningsfall som videostreaming, AI och maskininlärning. Beroende på prestandabehov kan du få upp till fyra kort per instans.

Quadro RTX 6000 har 4 608 CUDA-kärnor, 576 Tensor-kärnor, 72 RT-kärnor, 24 GB GDDR6 GPU-minne, 84T RTX-OPS, 10 Giga-strålar/sekund och en FP32-prestanda på 16,3 TFLOPS.

Priset för en dedikerad RTX 6000 GPU-plan ligger på $1,5 per timme.

Paperspace CORE

Förbättra din organisations arbetsflöde med nästa generations accelererade datorinfrastruktur via Paperspace CORE. Det erbjuder ett användarvänligt och enkelt gränssnitt, samarbetsverktyg och skrivbordsapplikationer för Mac, Linux och Windows. Du kan använda det för att köra applikationer med höga krav med hjälp av obegränsad datorprestanda.

CORE erbjuder ett snabbt nätverk, omedelbar provisionering, stöd för 3D-applikationer och ett fullständigt API för programmerad åtkomst. Få en överblick över din infrastruktur genom ett enkelt och intuitivt GUI. CORE:s hanteringsgränssnitt gör det möjligt att filtrera, sortera, ansluta eller skapa virtuella maskiner, nätverk och användare.

CORE:s kraftfulla hanteringskonsol utför uppgifter snabbt, såsom att integrera Active Directory eller VPN. Nätverkskonfigurationer kan hanteras enkelt, vilket effektiviserar arbetsprocessen.

Paperspace CORE har även många valfria integrationer som kan underlätta ditt arbete. Du får tillgång till avancerade säkerhetsfunktioner, delade enheter med mera. Med utbildningsrabatter, faktureringsaviseringar och sekundbaserad debitering blir tillgången till GPU:er kostnadseffektiv.

Förenkla ditt arbetsflöde med CORE till ett startpris på 0,07 USD per timme.

Google Cloud GPU:er

Använd högpresterande GPU:er för vetenskapliga beräkningar, 3D-visualisering och maskininlärning med Google Cloud GPU:er. Det kan bidra till att accelerera HPC (high-performance computing), genom att tillhandahålla ett stort urval av GPU:er som passar olika prisnivåer och prestandabehov, och du kan minimera arbetsbelastningen med anpassningsbara maskiner och flexibel prissättning.

De erbjuder ett stort utbud av grafikprocessorer som NVIDIA K80, P4, V100, A100, T4 och P100. Google Cloud GPU:er balanserar minne, processor, högpresterande diskar och upp till åtta GPU:er i varje instans för optimal anpassning till varje specifik arbetsbelastning.

Du får även tillgång till ett branschledande nätverk, dataanalys och lagring. GPU-enheter är tillgängliga i specifika zoner i vissa regioner. Priset beror på region, vald GPU och maskintyp. Du kan beräkna ditt pris genom att definiera dina krav i Google Cloud Pricing Calculator.

Alternativt kan du överväga dessa lösningar:

Elastisk GPU-tjänst

Elastisk GPU-tjänst (EGS) tillhandahåller kraftfull parallell beräkningskapacitet med GPU-teknik. Tjänsten är idealisk för scenarier som videobearbetning, visualisering, vetenskapliga beräkningar och djupinlärning. EGS använder grafikprocessorer som NVIDIA Tesla M40, NVIDIA Tesla V100, NVIDIA Tesla P4, NVIDIA Tesla P100 och AMD FirePro S7150.

Med EGS får du tjänster och verktyg för onlinetjänster och utbildning inom djupinlärning, innehållsidentifiering, bild- och röstigenkänning, HD-mediakodning, videokonferenser, reparation av äldre filmer samt 4K/8K HD-live.

Det finns även alternativ för videorendering, beräkningsfinansiering, klimatprognoser, kollisionssimuleringar, genteknik, icke-linjär redigering, distansutbildningsapplikationer och teknisk design.

- GA1-instansen har upp till fyra AMD FirePro S7150 GPU:er, 160 GB minne och 56 virtuella processorer. Den innehåller 8 192 kärnor och 32 GB GPU-minne som arbetar parallellt och levererar 15 TFLOPS med enkel precision och 1 TFLOPS med dubbel precision.

- GN4-instansen ger upp till två NVIDIA Tesla M40 GPU:er, 96 GB minne och 56 virtuella processorer. Den innehåller 6 000 kärnor och 24 GB GPU-minne som levererar 14 TFLOPS med enkel precision. Det finns även instanser som GN5, GN5i och GN6.

- EGS stöder 25 Gbit/s nätverksbandbredd internt, upp till 2 000 000 PPS, för att leverera den nätverksprestanda som krävs av beräkningsnoderna. Den har en snabb lokal cache ansluten med SSD eller ultramolndiskar.

- Högpresterande NVMe-enheter hanterar 230 000 IOPS med I/O-latens på 200 µs och ger 1 900 Mbit/s läsbandbredd och 1 100 Mbit/s skrivbandbredd.

Du kan välja mellan olika inköpsalternativ baserat på dina behov och betala enbart för de resurser du använder.

Azure N-serien

Azure N-serien av Azure Virtual Machines (VM) har GPU-funktioner. GPU:erna är idealiska för grafik- och beräkningsintensiva arbetsbelastningar och hjälper användare att främja innovation inom olika områden som djupinlärning, prediktiv analys och fjärrvisualisering.

Olika N-serier erbjuder separata lösningar för specifika arbetsbelastningar.

- NC-serien fokuserar på högpresterande maskininlärning och beräkningsbelastningar. Den senaste versionen, NCsv3, har NVIDIAs Tesla V100 GPU.

- ND-serien fokuserar på inferens och träning inom djupinlärning. Den använder NVIDIA Tesla P40 GPU:er. Den senaste versionen, NDv2, har NVIDIA Tesla V100 GPU:er.

- NV-serien fokuserar på fjärrvisualisering och andra intensiva applikationsbelastningar med stöd av NVIDIA Tesla M60 GPU.

- De virtuella maskinerna NC, NCsv3, ND och NCsv2 har InfiniBand-interconnect som möjliggör uppskalningsprestanda. Här finns möjligheter för djupinlärning, grafikrendering, videoredigering och spel.

IBM Cloud

IBM Cloud ger dig flexibilitet, kraft och många GPU-alternativ. GPU:er ger extra beräkningskraft som CPU:er saknar. IBM Cloud ger direkt tillgång till ett bredare urval av servrar med sömlös integration i IBM Clouds arkitektur, applikationer och API:er, tillsammans med ett distribuerat nätverk av datacenter globalt.

- Du får GPU-alternativ för bare metal-server som Intel Xeon 4210, NVIDIA T4-grafikkort, 20 kärnor, 32 GB RAM, 2,20 GHz och 20 TB bandbredd. Det finns även alternativ för Intel Xeon 5218 och Intel Xeon 6248.

- För virtuella servrar får du AC1.8×60 med åtta vCPU:er, 60 GB RAM och 1 x P100 GPU. Alternativ som AC2.8×60 och AC2.8×60 finns också tillgängliga.

Få tillgång till bare metal-server-GPU:er från 819 dollar per månad och virtuell server-GPU:er från 1,95 dollar per timme.

AWS och NVIDIA

AWS och NVIDIA samarbetar för att kontinuerligt leverera kostnadseffektiva, flexibla och kraftfulla GPU-baserade lösningar. Detta inkluderar NVIDIA GPU-drivna Amazon EC2-instanser och tjänster som AWS IoT Greengrass som distribueras med NVIDIA Jetson Nano-moduler.

Användare utnyttjar AWS och NVIDIA för virtuella arbetsstationer, maskininlärning (ML), IoT-tjänster och högpresterande datorsystem. Amazon EC2-instanser med NVIDIA GPU:er levererar skalbar prestanda. AWS IoT Greengrass utökar AWS-molntjänsterna till NVIDIA-baserade edge-enheter.

NVIDIA A100 Tensor Core GPU:er driver Amazon EC2 P4d-instanser med branschledande nätverk med låg latens och hög genomströmning. Det finns även många andra instanser för specifika scenarier, som Amazon EC2 P3, Amazon EC2 G4, etc.

Prova en GRATIS testperiod och upplev GPU-kraften från molnet.

OVHmoln

OVHmoln tillhandahåller molnservrar som är designade för att hantera stora parallella arbetsbelastningar. GPU:erna har många instanser integrerade med NVIDIA Tesla V100-grafikprocessorer för att möta behovet inom djupinlärning och maskininlärning.

De hjälper till att påskynda beräkningar inom grafik och artificiell intelligens. OVH samarbetar med NVIDIA för att erbjuda den bästa GPU-accelererade plattformen för högpresterande datorsystem, AI och djupinlärning.

Du kan enkelt driftsätta och underhålla GPU-accelererade containrar genom en komplett katalog. Varje instans har ett av fyra kort direkt via PCI Passthrough, utan virtualiseringslager, för att kunna dedikera all kraft till den egna användningen.

OVHclouds tjänster och infrastruktur är certifierade enligt ISO/IEC 27017, 27001, 27701 och 27018. Certifieringarna visar att OVHcloud har ett informationssäkerhetshanteringssystem (ISMS) för att hantera sårbarheter, implementera affärskontinuitet, hantera risker och implementera ett integritetsinformationshanteringssystem (PIMS).

NVIDIA Tesla V100 har bland annat funktioner som PCIe 32 GB/s, 16 GB HBM2-kapacitet, 900 GB/s bandbredd, dubbel precision-7 teraFLOPs, enkel precision-14 teraFLOPs och deep learning-112 teraFLOPs.

Lambda GPU

Träna modeller för djupinlärning, ML och AI med Lambda GPU Cloud och skala enkelt från en enda maskin till ett stort antal virtuella maskiner med bara några klick. Du får tillgång till förinstallerade ramverk och den senaste versionen av Lambda-stacken, inklusive CUDA-drivrutiner och ramverk för djupinlärning.

Varje maskin har sin egen dedikerade Jupyter Notebook-utvecklingsmiljö, som kan nås snabbt från instrumentpanelen. Du kan använda SSH direkt med en av SSH-nycklarna eller ansluta via webbterminalen på instrumentpanelen för direkt åtkomst.

Varje instans stöder maximalt 10 Gbps bandbredd mellan noder, vilket möjliggör distribuerad träning med ramverk som Horovod. Du kan även spara tid vid modelloptimering genom att skala antalet GPU:er på en eller flera instanser.

Med Lambda GPU Cloud kan du spara upp till 50 % på datoranvändning och minska molnets TCO, utan fleråriga bindningar. Använd en enkel RTX 6000 GPU med sex vCPU:er, 46 GiB RAM, 658 GiB tillfällig lagring för endast 1,25 USD per timme. Välj mellan många instanser enligt dina krav och få en prisuppgift för din specifika användning.

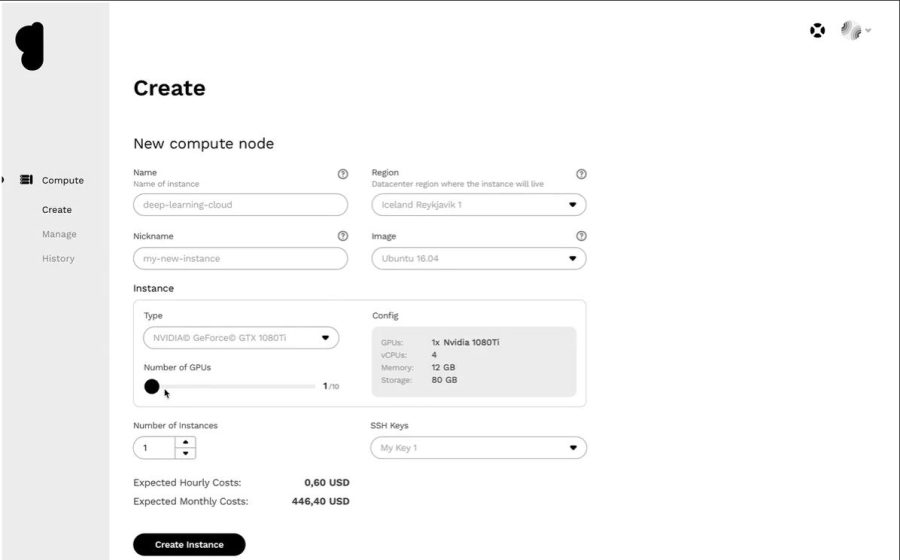

Genesis Cloud

Skaffa en effektiv moln-GPU-plattform till ett överkomligt pris från Genesis Cloud. De har tillgång till många effektiva datacenter i världen som de samarbetar med, vilket ger tillgång till ett brett utbud av applikationer.

Alla tjänster är säkra, skalbara, robusta och automatiserade. Genesis Cloud tillhandahåller obegränsad GPU-beräkningskraft för visuella effekter, maskininlärning, omkodning eller lagring, big data-analys med mera.

Genesis Cloud erbjuder många funktioner GRATIS, som ögonblicksbilder för att spara ditt arbete, säkerhetsgrupper för nätverkstrafiken, lagringsvolymer för stora datamängder, FastAI, PyTorch, förkonfigurerade bilder och ett offentligt API för TensorFlow.

De erbjuder NVIDIA och AMD GPU:er av olika typer. Träna neurala nätverk eller generera animerade filmer genom att utnyttja GPU-beräkningarnas kraft. Deras datacenter drivs med 100 % förnybar energi från geotermiska källor för att minska koldioxidutsläppen.

Deras prissättning är 85 % lägre än andra leverantörer med minutbaserad debitering. Dessutom kan du spara mer med långsiktiga rabatter.

Slutsats 👩🏫

Moln-GPU:er är designade för att leverera otrolig prestanda, hastighet, skalbarhet, utrymme och bekvämlighet. Överväg därför att välja en passande moln-GPU-plattform med alla verktyg du behöver för att påskynda dina djupinlärningsmodeller och hantera AI-arbetsbelastningar på ett effektivt sätt.