Vikten av Databearbetning för Bättre Analys

I dagens digitala era, där datamängderna växer exponentiellt och mätts i terabyte och petabyte, blir förmågan att omvandla denna data till användbar information allt viktigare. Hur kan vi effektivt konsumera och omvandla dessa enorma mängder rådata till värdefulla insikter som förbättrar våra tjänster?

Kvalitativ, aktuell och lättförståelig data är avgörande för alla företag som vill utveckla sina modeller för kunskapsinhämtning. För att säkerställa detta använder företag olika analysmetoder för att identifiera och extrahera data av hög kvalitet.

Men var börjar denna process? Svaret ligger i databearbetning.

Låt oss utforska detta ämne!

Vad är databearbetning?

Databearbetning, även kallat datawrangling, innebär processen att rengöra, strukturera och transformera rådata till ett format som förenklar dataanalys. Denna process hanterar ofta oorganiserade och komplexa datamängder som inte är direkt användbara för dataprocesser. Databearbetning förvandlar rådata till förfinade data eller förädlar data till en optimerad nivå som är redo för produktionsanvändning.

Vanliga aktiviteter inom databearbetning inkluderar:

- Att sammanfoga olika datamängder till en enda stor datamängd för analys.

- Att identifiera och åtgärda saknade data eller luckor i datamängder.

- Att ta bort extremvärden eller avvikelser i datamängder.

- Att standardisera datainmatningar.

De omfattande datamängder som hanteras inom databearbetning kräver ofta automatiserade metoder för att säkerställa noggrannhet och kvalitet, då manuell hantering blir praktiskt omöjlig.

Målsättningar med databearbetning

Utöver det huvudsakliga målet att förbereda data för analys, finns det flera andra viktiga mål:

- Att skapa användbar och pålitlig data från ostrukturerade datamängder, vilket möjliggör välgrundade affärsbeslut.

- Att standardisera rådata till format som är kompatibla med storskaliga datasystem.

- Att minska den tid som dataanalytiker lägger på att skapa datamodeller genom att tillhandahålla organiserad data.

- Att säkerställa konsekvens, fullständighet, användbarhet och säkerhet för all data som används eller lagras inom ett datalager.

Vanliga steg i databearbetning

Upptäckt

Innan datatekniker påbörjar förberedelseprocessen är det viktigt att förstå hur datan är lagrad, dess storlek, vilka register som finns, kodningsformat och andra egenskaper som definierar datamängderna.

Strukturering

Denna fas handlar om att organisera data i lättanvända format. Rådata kan behöva struktureras genom att justera kolumner, rader och andra dataattribut för att underlätta analys.

Rensning

Strukturerad data måste befrias från fel och allt som kan förvränga datan. Detta innebär att ta bort dubbletter, hantera tomma celler, ta bort extremvärden, standardisera data, byta namn på förvirrande attribut och mer.

Berikning

Efter strukturering och rensning är det viktigt att utvärdera nyttan av datan och utöka den med värden från andra datakällor som saknas, för att säkerställa önskad datakvalitet.

Validering

Valideringsprocessen innefattar iterativa programmeringsmoment som fokuserar på datakvalitet, konsekvens, användbarhet och säkerhet. Denna fas säkerställer att alla transformationer har genomförts korrekt och markerar datamängder som redo för analys och modellering.

Presentation

Efter alla bearbetningssteg presenteras de strukturerade datamängderna inom organisationen för analys. Dokumentation av förberedelseprocessen och metadata som genereras delas också i detta skede.

Datahanteringsverktyg

Det finns flera verktyg som hjälper till med databearbetning, och här går vi igenom några av de mest populära:

Talend

Talend är en enhetlig datahanteringsplattform som erbjuder robusta lösningar för dataintegration, applikationsintegration, datahantering och styrning. Talends databearbetningsfunktioner tillhandahålls via ett webbläsarbaserat pek-och-klick-verktyg som möjliggör batch-, bulk- och livedataförberedelser, inklusive dataprofilering, rensning och dokumentation.

Talends dataplattform hanterar varje steg i datans livscykel och balanserar datatillgänglighet, användbarhet, säkerhet och integritet.

Talends enhetliga metod erbjuder snabb dataintegration från olika källor som databaser, molnlagringar och API-slutpunkter, vilket möjliggör transformation och anpassning av data med kvalitetskontroller.

Dataintegration i Talend är möjlig tack vare självbetjäningsverktyg som kontakter, som gör det möjligt för utvecklare att automatiskt mata in data från valfri källa och kategorisera den korrekt.

Funktioner i Talend

Universell dataintegration

Talend låter företag bearbeta data från olika källor, oavsett om de finns i molnet eller lokalt.

Flexibilitet

Med Talend kan du inte bara bygga datapipelines från integrerad data utan också köra dessa pipelines var som helst.

Datakvalitet

Med funktioner för maskininlärning som datadeduplicering, validering och standardisering, rensar Talend automatiskt indata.

Stöd för applikation och API-integrationer

Efter att du har skapat en bra förståelse för din data genom Talends självbetjäningsverktyg, kan du dela datan via användarvänliga API:er. Talends API-slutpunkter kan exponera dina datatillgångar för SaaS-, JSON-, AVRO- och B2B-plattformar genom avancerade verktyg för datamappning och transformation.

R

R är ett programmeringsspråk som är utformat för utforskande dataanalys, för både vetenskapliga och affärsmässiga tillämpningar.

Som en fri programvara för statistisk beräkning och grafik, är R både ett språk och en miljö för databearbetning, modellering och visualisering. R-miljön innehåller en uppsättning mjukvarupaket, och R-språket innehåller statistiska, klustrings-, klassificerings- och grafiska tekniker för att manipulera data.

Funktioner hos R

Omfattande paketutbud

Dataingenjörer har tillgång till över 10 000 standardiserade paket och tillägg från Comprehensive R Archive Network (CRAN), vilket förenklar databearbetning och analys.

Kraftfull bearbetning

Med distribuerade beräkningspaket kan R utföra komplexa och enkla matematiska och statistiska manipulationer på dataobjekt och datamängder på kort tid.

Plattformsoberoende

R kan köras på olika operativsystem och är även kompatibelt med andra programmeringsspråk, vilket underlättar hanteringen av beräkningstunga uppgifter.

R är ett relativt lätt programmeringsspråk att lära sig.

Trifacta

Trifacta är en interaktiv molnmiljö för dataprofilering som använder maskininlärning och analysmodeller. Trifacta syftar till att skapa begriplig data, oavsett datans komplexitet. Användare kan ta bort dubbletter och fylla tomma celler i datamängder genom deduplicering och linjära transformationsfunktioner.

Verktyget är bra på att upptäcka extremvärden och ogiltig data. Med enkla klick och drag-funktioner kan data rankas och transformeras med hjälp av maskininlärningsbaserade förslag, vilket påskyndar databearbetningsprocessen.

Trifacta erbjuder visuella profiler som är tillgängliga för både teknisk och icke-teknisk personal. Med visualiserade och intelligenta transformationer är Trifacta utformat med användarvänlighet i fokus.

Oavsett om du hämtar data från datamarts, datalager eller datasjöar, är användare skyddade från komplexiteten i databearbetning.

Funktioner hos Trifacta

Smidiga molnintegrationer

Trifacta stöder databearbetning i olika moln- och hybridmiljöer, vilket gör det möjligt för utvecklare att hantera datamängder oavsett var de är lagrade.

Flera metoder för datastandardisering

Trifacta har flera mekanismer för att identifiera mönster i data och standardisera utdata, vilket gör det möjligt för dataingenjörer att välja standardisering efter mönster, funktion eller en kombination.

Enkelt arbetsflöde

Trifacta organiserar databearbetning i form av flöden. Ett flöde innehåller en eller flera datamängder plus deras associerade recept (steg som transformerar data).

Detta flöde gör att utvecklare kan minska den tid de lägger på att importera, bearbeta, profilera och exportera data.

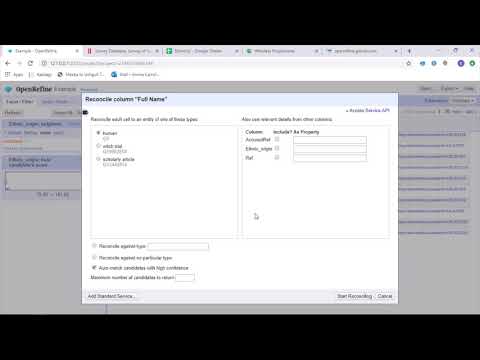

OpenRefine

OpenRefine är ett moget, öppen källkod-verktyg för att hantera ostrukturerad data. Som ett datarensningsverktyg utforskar OpenRefine datamängder snabbt, samtidigt som det använder komplexa celltransformationer för att presentera önskade dataformat.

OpenRefine hanterar databearbetning genom filter och partitioner på datamängder med reguljära uttryck. Genom att använda det inbyggda General Refine Expression Language kan dataingenjörer lära sig och visa data med hjälp av aspekter, filter och sorteringstekniker innan de utför avancerade dataoperationer för enhetsextraktioner.

OpenRefine låter användare arbeta med data i form av projekt, där datamängder från olika filer, webbadresser och databaser kan dras in i ett projekt och hanteras lokalt.

Genom uttryck kan utvecklare utföra datarensning och transformation, exempelvis genom att dela upp/sammanfoga celler med flera värden, anpassa aspekter och hämta data till kolumner med hjälp av externa webbadresser.

Funktioner i OpenRefine

Plattformsoberoende verktyg

OpenRefine är utformat för att fungera med Windows-, Mac- och Linux-operativsystem genom nedladdningsbara installationsfiler.

Omfattande API-utbud

OpenRefine har API:er för olika ändamål, inklusive datatillägg, synkronisering och annat som underlättar användarinteraktion med data.

Datameer

Datameer är ett SaaS-datatransformationsverktyg som är utformat för att förenkla databearbetning och integration inom programvaruutveckling. Datameer möjliggör extrahering, transformation och laddning av datamängder till molndatalager som Snowflake.

Datameer fungerar bra med standarddataformat som CSV och JSON, och gör det möjligt för ingenjörer att importera data i olika format för aggregering.

Datameer har katalogliknande datadokumentation, djup dataprofilering och upptäcktsfunktioner. Verktyget erbjuder visuella profiler som gör det enkelt för användare att spåra ogiltiga, saknade eller avvikande fält och värden, samt datans övergripande struktur.

Datameer transformerar data på ett skalbart datalager, vilket möjliggör meningsfull analys genom effektiva datastackar och excel-liknande funktioner.

Datameer erbjuder ett hybrid-, kod- och no-code gränssnitt för att tillgodose behoven hos olika dataanalysteam och underlättar byggandet av komplexa ETL-pipelines.

Funktioner i Datameer

Flera användarmiljöer

Datameer tillhandahåller miljöer för datatransformation för olika användare, oavsett teknisk kunskapsnivå. Det finns både lågkods-, kod- och hybridlösningar.

Delade arbetsytor

Datameer gör det möjligt för team att återanvända och samarbeta kring modeller, vilket påskyndar projekt.

Omfattande datadokumentation

Datameer stöder både system- och användargenererad datadokumentation genom metadata och beskrivningar, taggar och wikiliknande kommentarer.

Slutsats

Dataanalys är en komplex process som kräver korrekt organiserad data för att kunna dra meningsfulla slutsatser och göra tillförlitliga prognoser. Databearbetningsverktyg hjälper dig att formatera stora mängder rådata för att utföra avancerad analys. Välj det verktyg som bäst passar dina behov och bli en expert på dataanalys!

Du kanske också är intresserad av:

De bästa CSV-verktygen för att konvertera, formatera och validera data.