Utforska Världen av LLMOps: En Djupdykning i Verktyg och Plattformar

Om du är nyfiken på artificiell intelligens, kommer den här artikeln ge dig en grundlig förståelse för dess komplexitet. Jag guidar dig genom LLMOps-plattformarnas landskap och belyser de avgörande verktyg som finns tillgängliga för att testa, förfina och implementera stora språkmodeller (LLM).

De plattformar som vi kommer att granska spelar en central roll för att realisera språkmodellernas fulla potential och erbjuder innovativa lösningar för utveckling och hantering av dessa modeller.

Välrenommerade organisationer som Google, OpenAI och Microsoft förlitar sig på LLMOps-plattformar för att säkerställa noggranna tester, kontinuerlig optimering och effektiv distribution av sina språkmodeller, vilket resulterar i tillförlitliga och precisa resultat.

Eftersom LLMOps kan vara ett nytt koncept för många, låt oss börja med att bygga en grundläggande förståelse för vad LLMOps innebär, dess betydelse, funktioner och fördelar.

Med denna bakgrund kan vi sedan gå vidare till huvudsyftet – att identifiera de bästa verktygen för våra läsare baserat på deras specifika behov. Listan som presenteras i den här artikeln fungerar som en vägledning för att nå detta mål.

Vad Är LLMOps?

LLMOps står för Language Model Operations, det vill säga hantering av språkmodeller. Det handlar om att hantera, distribuera och förbättra stora språkmodeller som de som används inom AI. LLMOps innefattar verktyg och processer för att träna, testa och underhålla dessa modeller, vilket säkerställer att de presterar väl och bibehåller sin noggrannhet över tid.

Även om det är relativt enkelt att skapa prototyper av LLM:er, uppstår utmaningar när de ska användas i kommersiella produkter. LLM-utvecklingscykeln involverar komplexa steg som databearbetning, modelljustering och distribution, vilket kräver smidigt samarbete mellan olika team. LLMOps täcker hela denna cykel och säkerställer effektiv experimentering, implementering och förbättring.

För att skapa klarhet vill jag att du ska förstå vad en LLMOps-plattform är. En bra förståelse kommer att hjälpa dig att få ut mycket av den här artikeln.

En LLMOps-plattform främjar samarbetet mellan dataforskare och ingenjörer, vilket underlättar iterativ datautforskning. Det möjliggör samarbete i realtid, spårning av experiment, modellhantering och kontrollerad LLM-distribution. LLMOps automatiserar operationer, synkronisering och övervakning av maskininlärningslivscykeln.

Hur Fungerar LLMOps?

LLMOps-plattformar underlättar hela livscykeln för språkmodeller. De centraliserar databearbetning, möjliggör experiment och tillåter finjustering för specifika uppgifter. Dessa plattformar underlättar också smidig implementering, kontinuerlig övervakning och sömlös versionshantering.

Samarbete främjas, fel minimeras genom automatisering och kontinuerlig förbättring stöds. Sammantaget optimerar LLMOps hanteringen av språkmodeller för en mängd olika applikationer.

Fördelar med LLMOps

De främsta fördelarna som jag anser vara betydande är effektivitet, noggrannhet och skalbarhet. Här är en detaljerad genomgång av de fördelar som LLMOps erbjuder:

- Effektivitet: LLMOps-plattformar optimerar hela processen med utveckling, testning och distribution av språkmodeller, vilket leder till tids- och resursbesparingar.

- Samarbete: Dessa plattformar främjar ett smidigt samarbete mellan dataforskare, ingenjörer och andra intressenter, vilket resulterar i effektivt teamarbete.

- Noggrannhet: LLMOps säkerställer att modellernas noggrannhet bibehålls och förbättras över tid genom kontinuerlig övervakning och optimering.

- Automatisering: LLMOps automatiserar flera uppgifter, inklusive databearbetning och övervakning, vilket minskar behovet av manuellt arbete.

- Skalbarhet: Genom att effektivt skala upp modeller kan LLMOps-plattformar enkelt hantera ökade arbetsbelastningar eller krav.

- Enkel implementering: LLMOps säkerställer att modeller integreras smidigt i applikationer eller system, vilket minimerar distributionsutmaningar.

Sammanfattningsvis förbättrar LLMOps effektivitet, noggrannhet och skalbarhet samtidigt som det främjar samarbete, automatisering och enkel driftsättning.

Låt oss nu gå vidare till vår lista över plattformar. Denna lista är baserad på rekommendationer från adminvista.com, men valet av den bästa plattformen för just dig, baserat på dina behov och krav, ligger i dina händer.

Dify

Är du intresserad av den snabba utvecklingen inom LLM-teknik, som GPT-4, och nyfiken på deras praktiska användningsområden? Dify är skapad just för dig. Plattformen ger utvecklare, och även de som saknar stark teknisk bakgrund, möjligheten att snabbt bygga värdefulla applikationer med hjälp av stora språkmodeller. Dessa applikationer är inte bara användarvänliga, utan är också inställda på kontinuerlig förbättring.

Viktiga funktioner:

- Användarvänlig LLMOps-plattform: Utveckla AI-applikationer enkelt med GPT-4 och hantera dem visuellt.

- Kontextuell AI med dina data: Använd dokument, webbinnehåll eller konceptuella anteckningar som AI-kontext. Dify hanterar förbearbetning med mera, vilket sparar utvecklingstid.

- Frigör potentialen i LLM:er: Dify säkerställer sömlös modellåtkomst, kontextinbäddning, kostnadskontroll och datakommentarer för smidig AI-utveckling.

- Färdiga mallar: Välj bland dialog- och textgenereringsmallar, redo att anpassas för dina specifika applikationer.

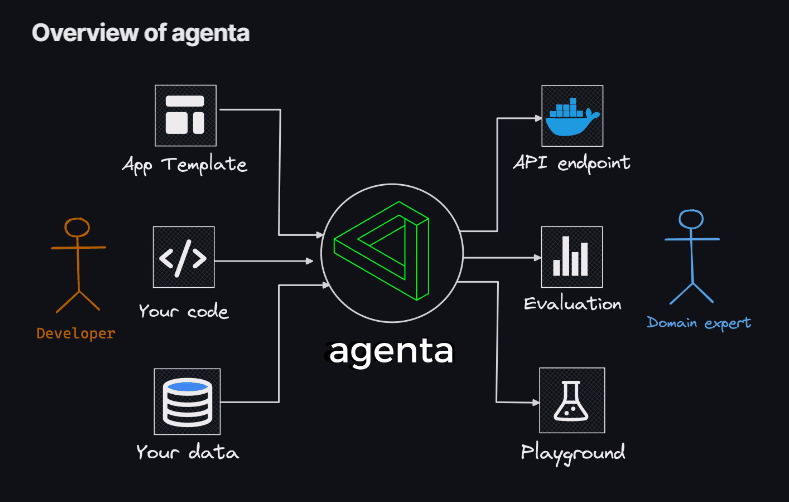

Agenta

Om du söker flexibiliteten att använda kod för att skapa LLM-appar, utan begränsningar från specifika modeller, bibliotek eller ramverk, är Agenta lösningen. Agenta är en öppen källkodsplattform som är designad för att underlätta processen att ta komplexa LLM-applikationer i produktion.

Med Agenta kan du snabbt experimentera med olika versioner av uppmaningar, parametrar och strategier, inklusive inlärning med kontext via inbäddningar, agenter och anpassad affärslogik.

Viktiga funktioner:

- Parameterutforskning: Ange applikationens parametrar direkt i koden och experimentera med dem via ett användarvänligt webbgränssnitt.

- Prestandabedömning: Utvärdera applikationens effektivitet med hjälp av testset och en mängd metoder som exakt matchning, AI-granskning, mänsklig utvärdering med mera.

- Testramverk: Skapa enkelt testset med hjälp av användargränssnittet, genom att ladda upp CSV-filer eller ansluta till dina data via API:et.

- Samarbetsmiljö: Främja samarbete genom att dela applikationen med andra och bjuda in till feedback.

- Enkel implementering: Distribuera applikationen som ett API med ett enkelt klick, vilket effektiviserar distributionsprocessen.

Agenta möjliggör också samarbete med experter för att snabbt bygga och utvärdera applikationer. En annan viktig funktion är Agentas förmåga att systematiskt utvärdera LLM-appar och underlätta implementeringen med ett enda klick.

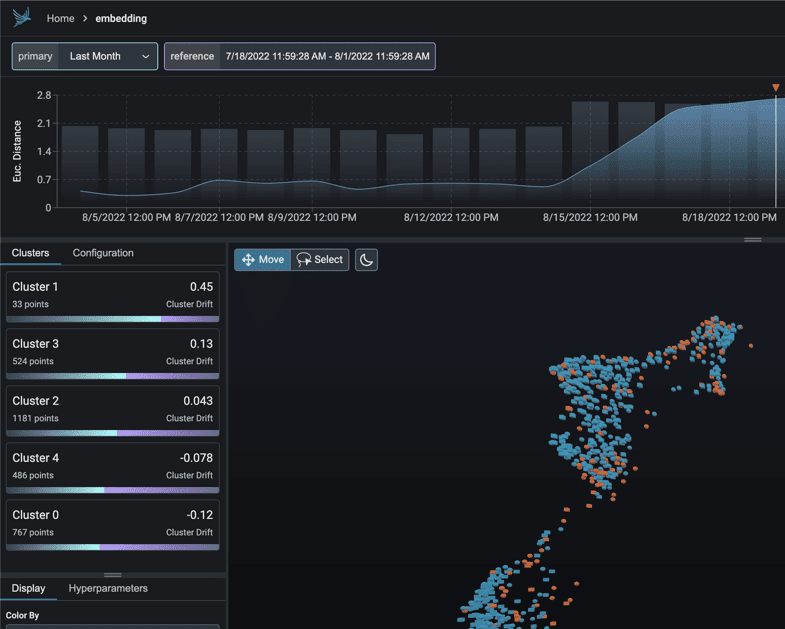

Phoenix

Utforska MLOps-insikter med Phoenix. Detta verktyg ger insyn i modellprestanda, drift och datakvalitet, utan komplexa konfigurationer.

Som ett Python-bibliotek med anteckningsböcker i fokus, använder Phoenix inbäddningar för att avslöja dolda detaljer i LLM-, CV-, NLP- och tabellmodeller. Förbättra dina modeller med de möjligheter som Phoenix erbjuder.

Viktiga funktioner:

- Undersökning av inbäddad drift: Granska UMAP-punktmoln under tillfällen av betydande euklidiska avstånd och exakta driftkluster.

- Drift- och prestandaanalys via klustring: Dela upp dina data i kluster med betydande drift eller lägre prestanda med HDBSCAN.

- UMAP-driven utforskande dataanalys: Skugga UMAP-punktmoln baserat på modellattribut, drift och prestanda och identifiera problematiska segment.

LangKit

LangKit är en verktygslåda med öppen källkod för textmått, utformad för att effektivt övervaka stora språkmodeller.

Syftet med LangKit är att hantera de risker som uppstår när språkmodeller, inklusive LLM:er, implementeras i produktion. De otaliga potentiella inmatningskombinationerna, som leder till lika många utdata, utgör en betydande utmaning.

Viktiga funktioner:

- Snabb injektionsanalys: Mät likhetspoäng med kända snabba injektionsattacker.

- Sentimentanalys: Bedöm sentimentet i texten.

- Textkvalitetsbedömning: Utvärdera läsbarhet, komplexitet och betyg.

- Jailbreak-detektion: Identifiera likhetspoäng med kända jailbreak-försök.

- Toxicitetsanalys: Detektera toxicitet i innehållet.

Textens ostrukturerade karaktär komplicerar frågor inom ML-observerbarhet, en utmaning som behöver åtgärdas. Bristen på insikt i en modells beteende kan ha betydande konsekvenser.

LiteLLM

Med LiteLLM förenklar du interaktionen med olika LLM API:er – Anthropic, Huggingface, Cohere, Azure OpenAI med flera – med hjälp av ett lättviktspaket i OpenAI-formatet.

Detta paket förenklar processen att anropa API-slutpunkter från leverantörer som OpenAI, Azure, Cohere och Anthropic. Det översätter indata till respektive leverantörs kompletterings- och inbäddningsslutpunkter, vilket säkerställer enhetlig utdata. Du kan alltid komma åt textsvar i [‘choices’][0][‘message’][‘content’].

Viktiga funktioner:

- Strömlinjeformad LLM API-anrop: Förenklar interaktion med LLM API:er som Anthropic, Cohere, Azure OpenAI med mera.

- Lättviktspaket: En kompakt lösning för att anropa API-slutpunkter från OpenAI, Azure, Cohere och Anthropic.

- Indataöversättning: Hanterar översättningen av indata till respektive leverantörs kompletterings- och inbäddningsslutpunkter.

- Undantagsmappning: Mappar vanliga undantag mellan leverantörer till OpenAI-undantagstyper för enhetlig felhantering.

Dessutom inkluderar paketet en undantagsmappningsfunktion som anpassar standardundantag mellan olika leverantörer med OpenAI-undantagstyper, vilket säkerställer konsekvens i felhanteringen.

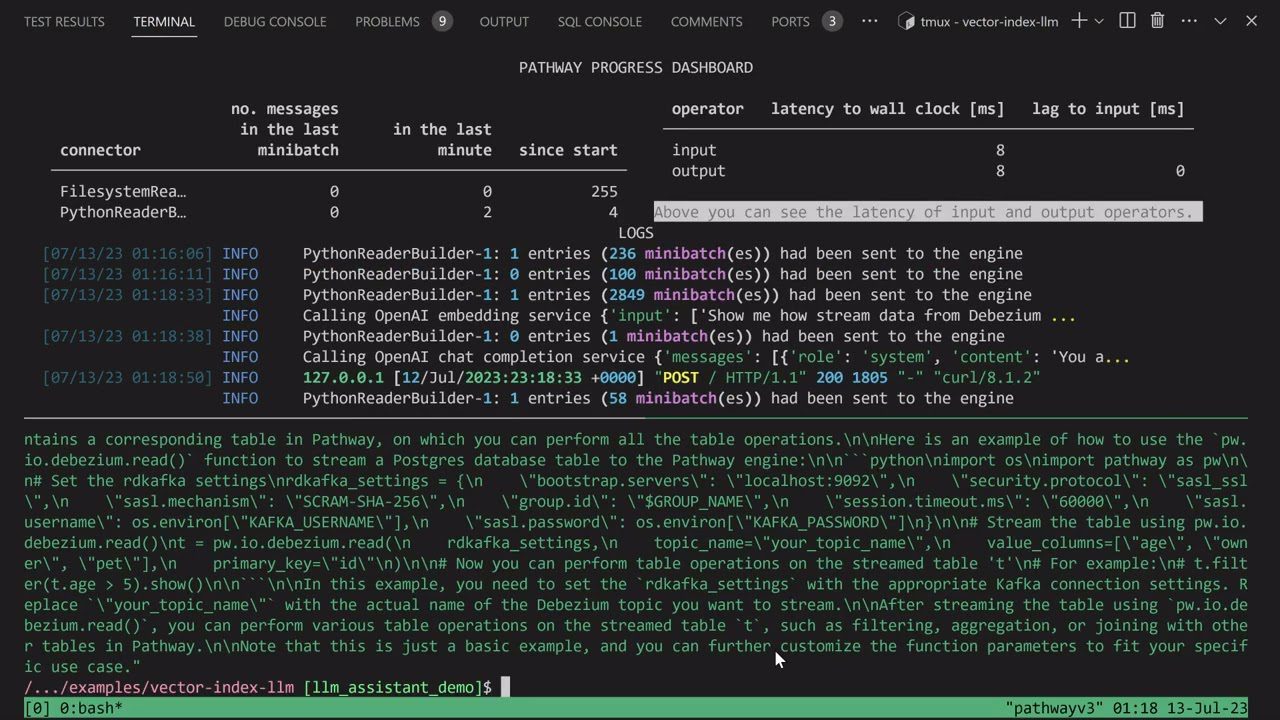

LLM-app

Skapa en unik Discord AI-chattbot med förmågan att svara på frågor, eller utforska liknande AI-botidéer. Alla dessa funktioner är tillgängliga genom LLM-app.

Jag presenterar Pathways LLM-App, ett Python-bibliotek som är designat för att påskynda utvecklingen av innovativa AI-applikationer.

Viktiga funktioner:

- Anpassad för lokala ML-modeller: LLM-appen är konfigurerad för att köras med lokala ML-modeller inom organisationens gränser.

- Datahantering i realtid: Biblioteket hanterar live-datakällor som nyhetsflöden, API:er och Kafka-dataströmmar, med användarbehörigheter och säkerhet.

- Smidiga användarsessioner: Bibliotekets frågebyggnadsprocess hanterar användarsessioner effektivt och säkerställer sömlösa interaktioner.

Detta verktyg ger dig möjlighet att ge omedelbara svar som liknar mänskliga interaktioner när du hanterar användarfrågor. Detta åstadkoms genom att dra nytta av de senaste insikterna i dina datakällor.

LLMFlows

LLMFlows är ett ramverk som är skräddarsytt för att förenkla, förtydliga och skapa transparens i utvecklingen av LLM-applikationer som chatbots, frågesvarssystem och agenter.

Komplexiteten kan öka i verkliga scenarier på grund av komplicerade relationer mellan uppmaningar och LLM-anrop.

Skaparna av LLMFlows utvecklade ett API som ger användare möjlighet att skapa ren och begriplig kod. Detta API effektiviserar skapandet av komplicerade LLM-interaktioner, vilket säkerställer ett smidigt flöde mellan olika modeller.

Viktiga funktioner:

- Konfigurera LLM-klasser smidigt, med noggrant val av specifika modeller, parametrar och inställningar.

- Säkerställ robust LLM-interaktion med automatiska återförsök vid fel, vilket säkerställer tillförlitlighet.

- Optimera prestanda och effektivitet genom att använda Async Flows för parallell körning av LLM när indata är tillgängliga.

- Integrera egna stränghanteringsfunktioner i flöden, vilket möjliggör skräddarsydda textomvandlingar utöver LLM-anrop.

- Behåll full kontroll över LLM-applikationer med hjälp av callback-funktioner, som erbjuder övervakning och transparens i körningsprocesserna.

LLMFlows klasser ger användare kontroll utan dolda uppmaningar eller LLM-anrop.

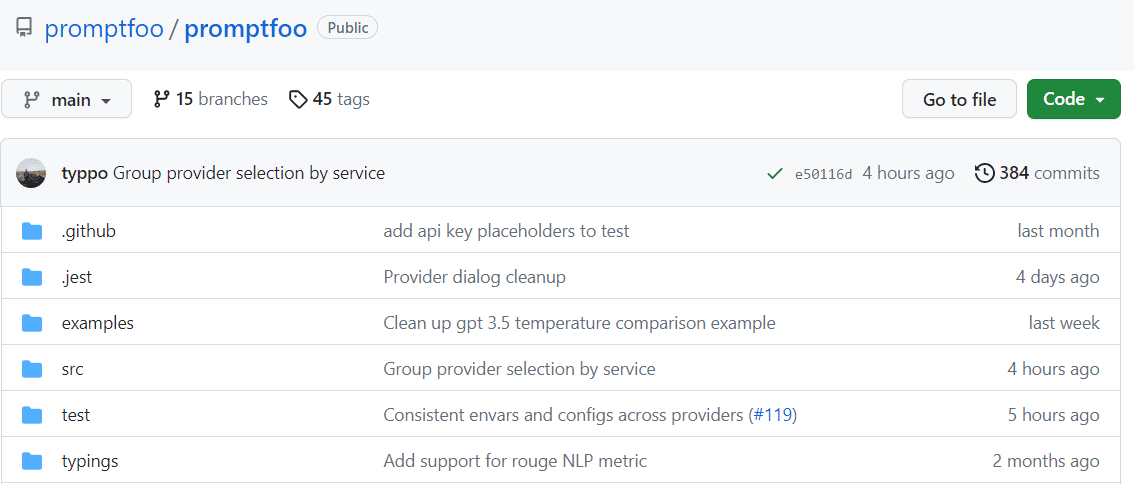

Promptfoo

Påskynda utvärderingar genom cachning och samtidiga tester med hjälp av promptfoo. Plattformen erbjuder ett kommandoradsgränssnitt (CLI) och ett bibliotek, vilket möjliggör bedömning av kvaliteten på LLM-utdata.

Viktiga funktioner:

- Beprövad tillförlitlighet: Promptfoo är designat för att utvärdera och förbättra LLM-appar som används av över 10 miljoner användare i en produktionsmiljö. Verktyget är flexibelt och kan anpassas till olika inställningar.

- Användarvänliga testfall: Definiera utvärderingar utan att koda eller använda krångliga anteckningsböcker. Ett enkelt och deklarativt tillvägagångssätt effektiviserar processen.

- Språkflexibilitet: Oavsett om du använder Python, JavaScript eller ett annat språk, är promptfoo anpassat efter dina behov.

Promptfoo möjliggör systematisk testning av prompter mot fördefinierade testfall. Detta hjälper till att utvärdera kvaliteten och identifiera regressioner genom att underlätta direkt jämförelse av LLM-utdata sida vid sida.

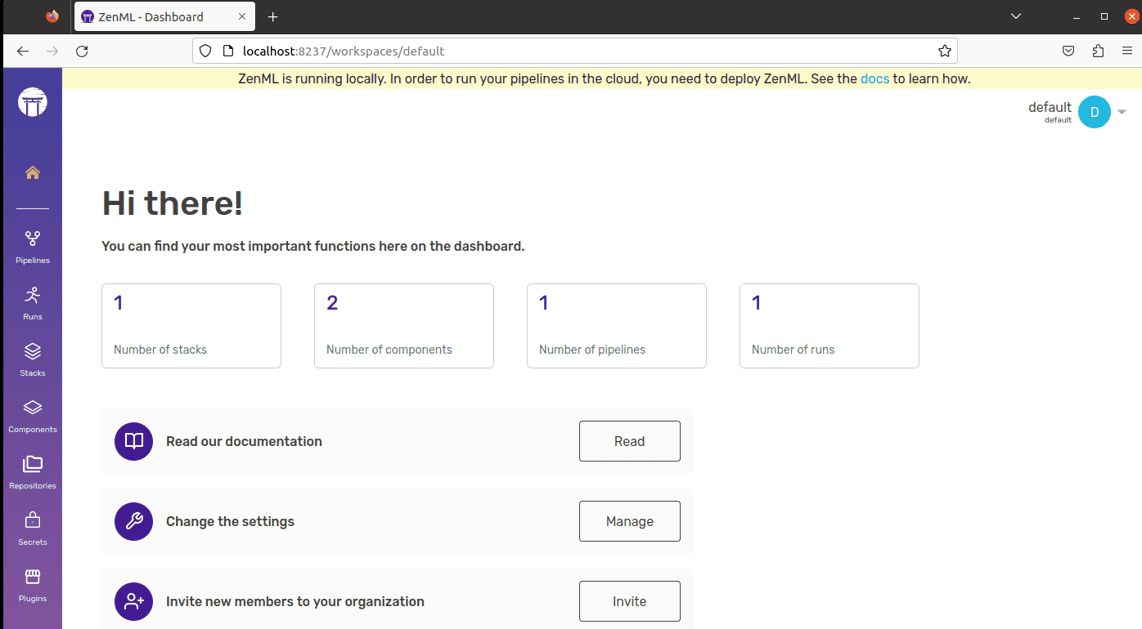

ZenML

Lär känna ZenML – ett anpassningsbart verktyg med öppen källkod som är designat för att förenkla maskininlärningspipelines för yrkesverksamma och organisationer. Tänk dig ett verktyg som gör det möjligt att skapa maskininlärningspipelines redo för användning i verkligheten, oavsett hur komplext ditt projekt är.

ZenML skiljer de tekniska detaljerna från koden, vilket gör det enklare för utvecklare, dataforskare, MLOps-experter och ML-ingenjörer att samarbeta. Detta innebär att dina projekt kan gå från idé till färdig produkt smidigare.

Viktiga funktioner:

- För dataforskare: Fokusera på att skapa och testa modeller medan ZenML förbereder din kod för verklig användning.

- För MLOps-experter: Konfigurera, hantera och distribuera komplexa system snabbt så att dina kollegor kan använda dem utan problem.

- För ML-ingenjörer: Hantera alla steg i ditt maskininlärningsprojekt, från början till slut, med hjälp av ZenML. Detta innebär mindre överlämning av arbete och större insyn i organisationens arbete.

ZenML är gjort för alla – oavsett om du är en professionell eller del av en organisation. Det erbjuder ett sätt att skriva kod som är anpassat för maskininlärningsuppgifter och fungerar bra med alla molntjänster eller verktyg du använder. Dessutom hjälper det dig att hantera ditt projekt på ett ställe, så att du slipper jonglera med olika verktyg. Du behöver bara skriva din kod en gång och sedan använda den enkelt i andra system.

Slutsats

Kom ihåg att varje plattform är en unik nyckel som kan öppna dörren till dina AI-ambitioner. Ditt val kommer att forma din väg, så välj klokt!

Du kan också utforska några AI-verktyg för utvecklare för att bygga applikationer snabbare.