SEO-loggfilsanalys hjälper till att förstå sökrobotens beteende på webbplatsen och identifiera potentiella tekniska SEO-optimeringsmöjligheter.

SEO utan att analysera sökrobotarnas beteende är som att flyga blind. Du kanske har skickat in webbplatsen på Googles sökkonsol och indexerat den, men utan att studera loggfilerna kommer du inte att få en uppfattning om din webbplats genomsöks eller läses av sökmotorrobotar ordentligt eller inte.

Det är därför jag har samlat allt du behöver veta för att analysera SEO-loggfiler och identifiera problem och SEO-möjligheter från dem.

Innehållsförteckning

Vad är loggfilsanalys?

SEO Log Files Analysis är en process för att känna igen mönstret av sökmotorrobotars interaktion med webbplatsen. Loggfilsanalys är en del av teknisk SEO.

Granskning av loggfiler är viktigt för SEO:er för att känna igen och lösa problemen med genomsökning, indexering och statuskoder.

Vad är loggfiler?

Loggfiler spårar vem som besöker en webbplats och vilket innehåll de ser. De innehåller information om vem som begärde tillgång till webbplatsen (även känd som ”Kunden”).

Informationen som uppfattas kan relateras till sökmotorrobotar som Google eller Bing eller en webbplatsbesökare. Vanligtvis samlas loggfilsposter in och underhålls av webbplatsens webbserver, och de sparas vanligtvis under en viss tid.

Vad innehåller loggfilen?

Innan du vet vikten av loggfiler för SEO är det viktigt att veta vad som finns i den här filen. Loggfilen e innehåller följande datapunkter:-

- Sidadress som webbplatsbesökaren efterfrågar

- HTTP-statuskoden för sidan

- Begärd server-IP-adress

- Datum och tid för träffen

- Data från användaragenten (sökmotorbot) som gör en begäran

- Begärningsmetod (GET/POST)

Loggfiler kan verka komplicerade för dig om du tittar på dem först. Ändå, när du väl vet syftet och betydelsen av loggfiler för SEO, kommer du att använda dem effektivt för att generera värdefulla SEO-insikter.

Syftet med loggfilsanalys för SEO

Loggfilsanalys hjälper till att lösa några av de viktiga tekniska SEO-problemen, vilket gör att du kan skapa en effektiv SEO-strategi för att optimera webbplatsen.

Här är några SEO-problem som kan analyseras med loggfiler:

#1. Hur ofta Googlebot genomsöker webbplatsen

Sökmotorrobotar eller sökrobotar bör genomsöka dina viktiga sidor ofta så att sökmotorn känner till dina webbplatsuppdateringar eller nytt innehåll.

Dina viktiga produkt- eller informationssidor bör alla visas i Googles loggar. En produktsida för en produkt som du inte längre säljer, liksom avsaknaden av någon av dina viktigaste kategorisidor, är indikatorer på ett problem som kan identifieras med hjälp av loggfiler.

Hur använder en sökmotorbot genomsökningsbudgeten?

Varje gång en sökmotors sökrobot besöker din webbplats har den en begränsad ”genomsökningsbudget”. Google definierar en genomsökningsbudget som summan av en webbplatss genomsökningshastighet och genomsökningsefterfrågan.

Genomsökning och indexering av en webbplats kan försvåras om den har många lågvärdiga webbadresser eller webbadresser som inte har skickats in korrekt i webbplatskartan. Genomsökning och indexering av nyckelsidor är lättare om din genomsökningsbudget är optimerad.

Loggfilsanalys hjälper till att optimera genomsökningsbudgeten som påskyndar SEO-ansträngningarna.

#2. Mobile-first indexeringsproblem och status

Mobile-first indexering är nu viktigt för alla webbplatser, och Google föredrar det. Loggfilsanalys kommer att berätta hur ofta smarttelefonen Googlebot genomsöker din webbplats.

Denna analys hjälper webbansvariga att optimera webbsidorna för mobilversioner om sidorna inte genomsöks korrekt av smartphone Googlebot.

#3. HTTP-statuskod som returneras av webbsidor vid begäran

De senaste svarskoderna som våra webbsidor returnerar kan hämtas antingen via loggfiler eller med alternativet hämta och återge begäran i Google Search Console.

Loggfilsanalysatorer kan hitta sidorna med 3xx-, 4xx- och 5xx-koderna. Du kan lösa dessa problem genom att vidta lämpliga åtgärder, till exempel omdirigera webbadresserna till rätt destinationer eller ändra 302 staus kodad till 301.

#4. Analysera genomsökningsaktiviteter som genomsökningsdjup eller interna länkar

Google uppskattar din webbplatsstruktur baserat på dess genomsökningsdjup och interna länkar. Orsaker bakom felaktig genomsökning av webbplatsen kan vara dålig sammankopplingsstruktur och genomsökningsdjup.

Om du har några problem med din webbplats hierarki eller webbplatsstruktur, eller interlink-struktur, kan du använda loggfilsanalys för att hitta dem.

Loggfilsanalys hjälper till att optimera webbplatsens arkitektur och sammanlänkningsstruktur.

#4. Upptäck föräldralösa sidor

Föräldralösa sidor är de webbsidor på webbplatsen som inte är länkade från någon annan sida. Det är svårt för sådana sidor att bli indexerade eller dyka upp i sökmotorer eftersom de inte är lätta att upptäcka av botar.

Föräldralösa sidor kan lätt upptäckas av sökrobotar som Screaming Frog, och det här problemet kan lösas genom att länka samman dessa sidor till de andra sidorna på webbplatsen.

#5. Granska sidorna för sidhastighet och upplevelse

Sidupplevelse och grundläggande webbviktigheter är officiellt rankningsfaktorerna nu, och det är viktigt nu att webbsidor är kompatibla med Googles riktlinjer för sidhastighet.

Långsamma eller stora sidor kan upptäckas med hjälp av loggfilsanalysatorer, och dessa sidor kan optimeras för sidhastighet som kommer att hjälpa till med den övergripande rankningen på SERP.

Loggfilsanalys hjälper dig att få kontroll över hur din webbplats genomsöks och hur sökmotorer hanterar din webbplats

Nu, eftersom vi är tydliga med grunderna för loggfiler och deras analys, låt oss titta på processen att granska loggfilerna för SEO

Hur man gör loggfilsanalys

Vi har redan tittat på olika aspekter av loggfiler och vikten av SEO. Nu är det dags att lära sig processen för att analysera filerna och de bästa verktygen för att analysera loggfilerna.

Du behöver tillgång till webbplatsens serverloggfil för att komma åt loggfilen. Filerna kan analyseras på följande sätt:

Det finns olika steg för att komma åt loggfilerna manuellt.

- Samla in eller exportera loggdata från webbservern och data bör filtreras för sökmotorrobotar eller sökrobotar.

- Konvertera den nedladdade filen till ett läsbart format med hjälp av dataanalysverktyg.

- Analysera data manuellt med excel eller andra visualiseringsverktyg för att hitta SEO-luckor och möjligheter.

- Du kan också använda filtreringsprogram och kommandorader för att göra ditt jobb enkelt

Att manuellt arbeta med filers data är inte lätt eftersom det kräver kunskaper i Excel och involverar utvecklingsteamet. Ändå gör verktyg för loggfilsanalys jobbet enkelt för SEOs.

Låt oss titta på de bästa verktygen för att granska loggfilerna och förstå hur dessa verktyg hjälper oss att analysera loggfilerna.

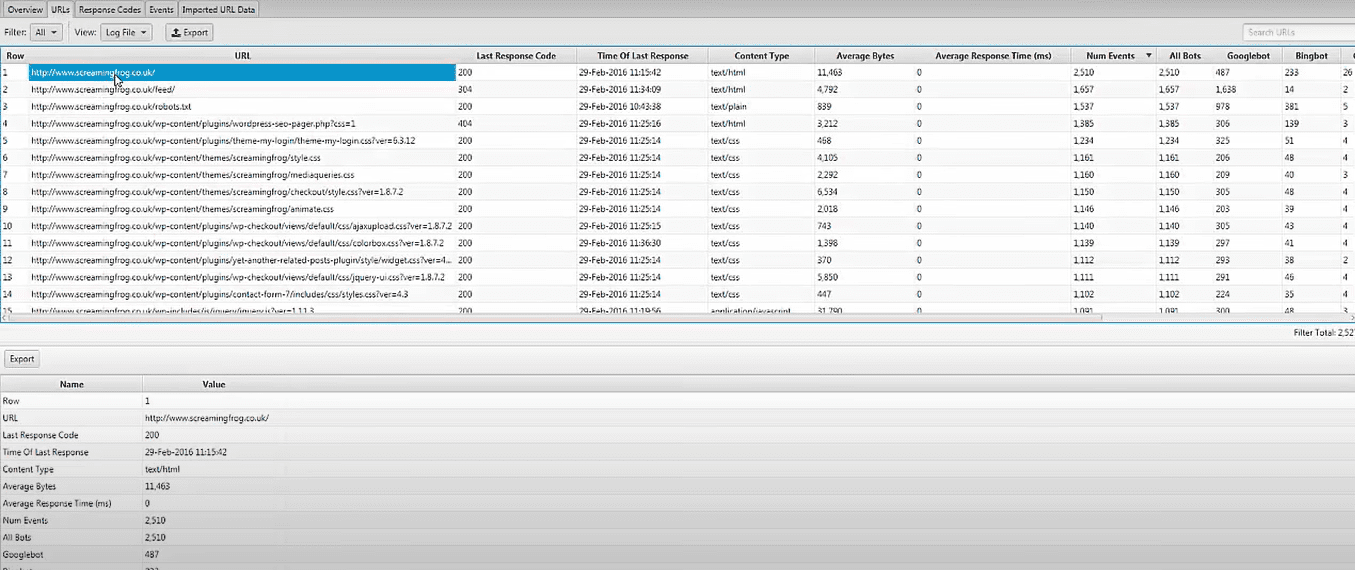

Screaming Frog Log File Analyzer

Tekniska SEO-problem kan identifieras med uppladdade loggfildata och sökmotorrobotar som verifieras med hjälp av Screaming Frog Log File Analyzer. Du kan också göra så här:

- Sökmotorbotaktivitet och data för sökmotoroptimering.

- Upptäck webbplatsens genomsökningsfrekvens av sökmotorrobotar

- Ta reda på om alla tekniska SEO-problem och externa och interna trasiga länkar

- Analys av webbadresser som har genomsökts minst och mest för att minska förlusten och öka effektiviteten.

- Upptäck sidor som inte genomsöks av sökmotorer.

- Alla data kan jämföras och kombineras, vilket inkluderar externa länkdata, direktiv och annan information.

- Visa data om hänvisningsadresser

Screaming Frog-loggfilanalysverktyget är helt gratis att använda för ett enda projekt med en gräns på 1000 radlogghändelser. Du måste uppgradera till betalversionen om du vill ha obegränsad åtkomst och teknisk assistans.

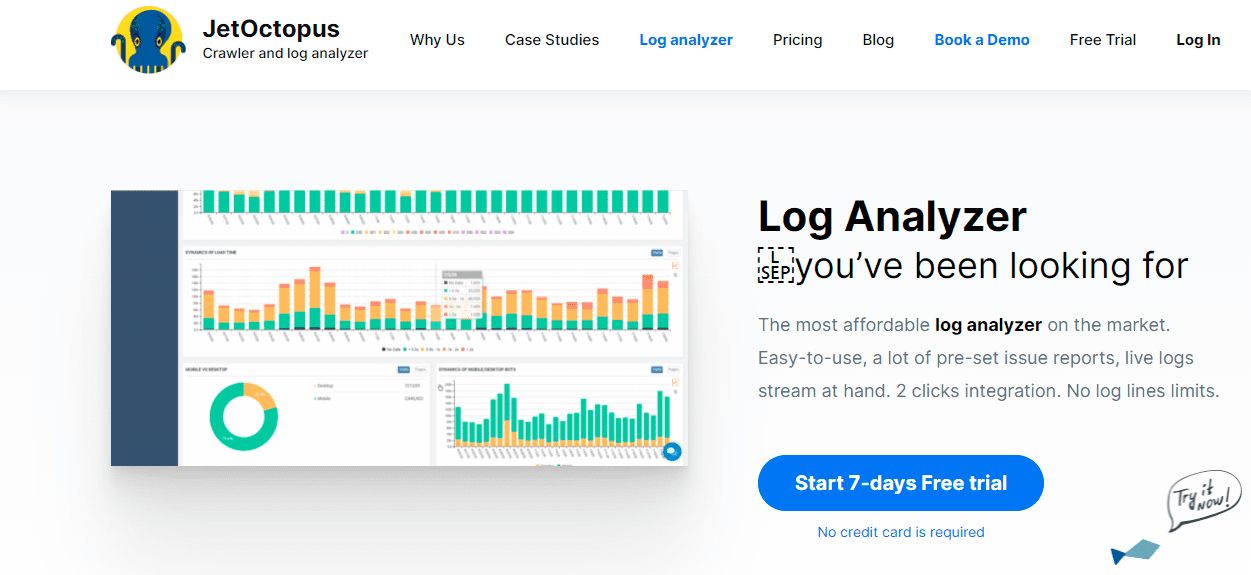

JetOctopus

När det gäller prisvärda logganalysverktyg är JetOctopus bäst. Den har en sju dagars gratis provperiod, inget kreditkort krävs och en anslutning med två klick. Genomsökningsfrekvens, genomsökningsbudget, populäraste sidor och mer kan alla identifieras med hjälp av JetOctopus logganalysatorprecis som de andra verktygen på vår lista.

Med det här verktyget kan du integrera loggfildata med Google Search Console-data, vilket ger dig en klar fördel gentemot konkurrenterna. Med den här kombinationen kommer du att kunna se hur Googlebot interagerar med din webbplats och var du kan förbättra dig.

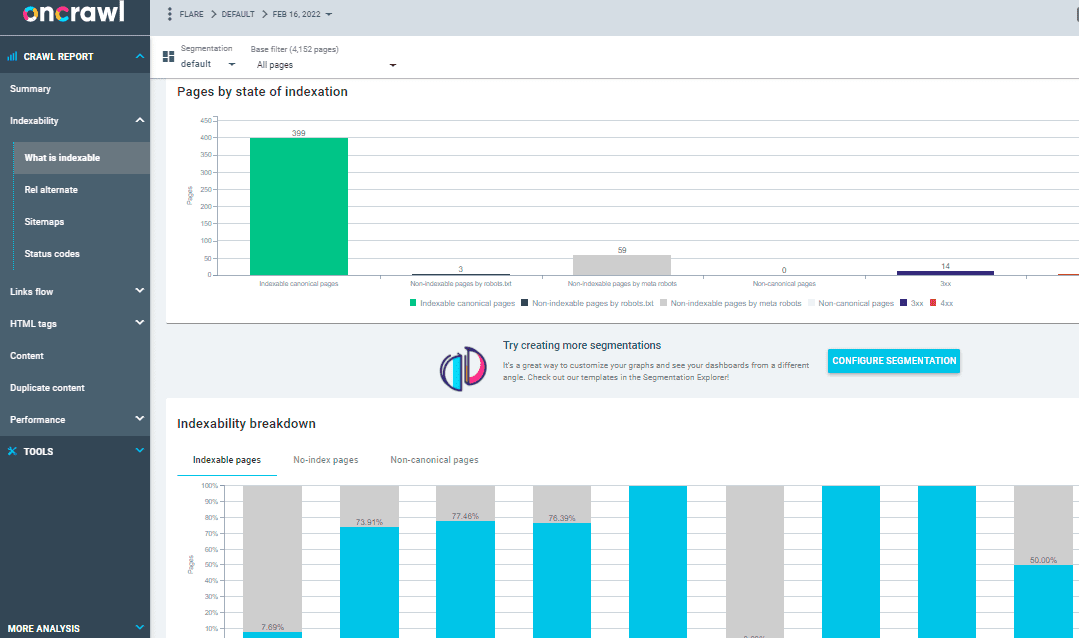

På Crawl Log Analyzer

Över 500 miljoner loggrader per dag bearbetas av Oncrawl Log Analyzer, ett verktyg designat för medelstora till stora webbplatser. Den håller ett öga på dina webbserverloggar i realtid för att säkerställa att dina sidor indexeras och genomsöks ordentligt.

Oncrawl Log Analyzer är GDPR-kompatibel och mycket säker. Istället för IP-adresser lagrar programmet alla loggfiler i ett säkert och segregerat FTP-moln.

Förutom JetOctopus och Screaming Frog Log File Analyzer har Oncrawl några fler funktioner, som:

- Stöder många loggformat, såsom IIS, Apache och Nginx.

- Verktyget anpassar sig enkelt till dina bearbetnings- och lagringskrav när de ändras

- Dynamisk segmentering är ett kraftfullt verktyg för att avslöja mönster och samband i din data genom att gruppera dina webbadresser och interna länkar baserat på olika kriterier.

- Använd datapunkter från dina råloggfiler för att skapa handlingsbara SEO-rapporter.

- Loggfiler som överförs till ditt FTP-utrymme kan automatiseras med hjälp av teknisk personal.

- Alla populära webbläsare kan övervakas, det inkluderar Google, Bing, Yandex och Baidus sökrobotar.

OnCrawl Log Analyzer har ytterligare två viktiga verktyg:

Oncrawl SEO Crawler: Med Oncrawl SEO Crawler kan du genomsöka din webbplats i hög hastighet och med minimala resurser. Förbättrar användarens förståelse för hur rankningskriterier påverkar sökmotoroptimering (SEO).

Vid genomsökningsdata: Oncrawl-data analyserar alla SEO-faktorer genom att kombinera data från genomsökningen och analys. Den hämtar data från genomsöknings- och loggfilerna för att förstå genomsökningsbeteendet och rekommenderar genomsökningsbudgeten för att prioritera innehåll eller ranka sidor.

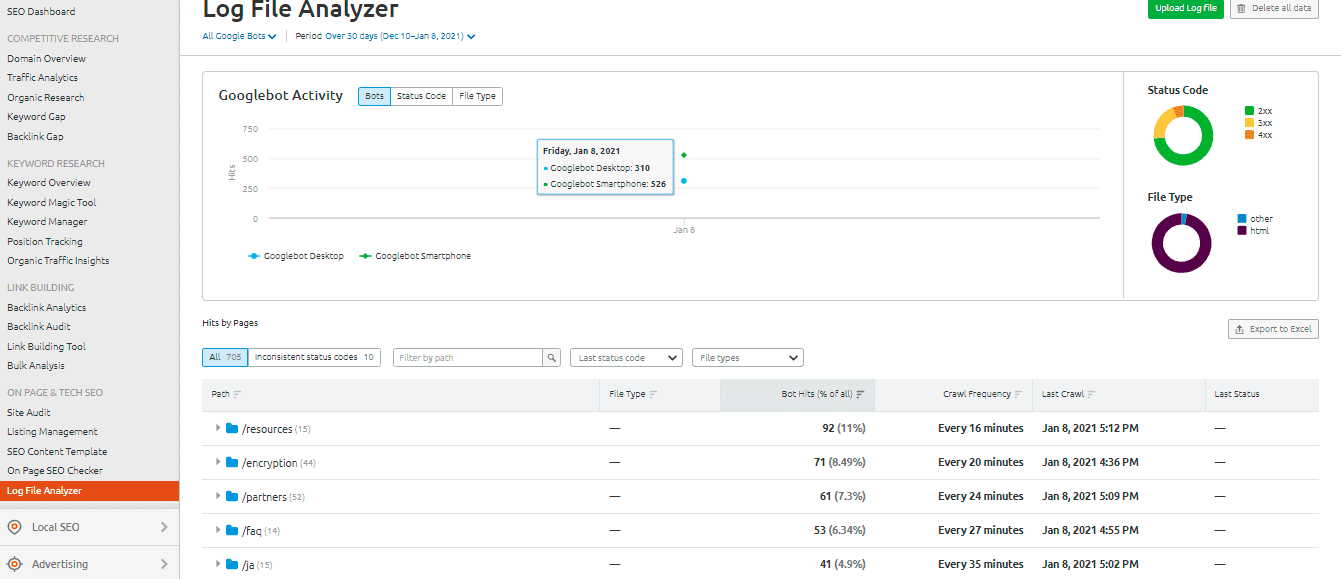

SEMrush Log File Analyzer

De SEMrush Log File Analyzer är ett smart val för ett enkelt, webbläsarbaserat logganalysverktyg. Denna analysator kräver ingen nedladdning och kan användas i onlineversionen.

SEMrush presenterar två rapporter:

Pages träffar: Sidornas träffar rapporterar sökrobotarnas interaktion med din webbplats innehåll. Det ger dig information om sidor, mappar och webbadresser med maximalt och minsta möjliga interaktion med bots.

Googlebots aktivitet: Googlebot-aktivitetsrapporten ger dagligen webbplatsrelaterade insikter, som:

- Typerna av genomsökta filer

- Den övergripande HTTP-statuskoden

- Antalet förfrågningar som gjorts till din webbplats av olika bots

Loggly från SolarWinds

SolarWinds’ Loggly undersöker åtkomst- och felloggarna för din webbserver, såväl som webbplatsens veckostatistik. Du kan se dina loggdata när som helst, och den har funktioner som gör det enkelt att söka igenom loggar.

Ett robust loggfilanalysverktyg som SolarWinds Loggly krävs för att effektivt bryta loggfilerna på din webbserver för information om framgång eller misslyckande av resursbegäranden från klienter.

Loggly kan tillhandahålla diagram som visar de minst sedda sidorna och beräkna genomsnittliga, lägsta och högsta sidladdningshastigheter för att hjälpa dig att optimera din webbplatss sökmotoroptimering.

Genomsökningsstatistik för Google Search Console

Google Search Console gjort det enklare för användarna genom att ge en användbar översikt över dess praxis. Konsolens funktion är enkel. Din genomsökningsstatistik kommer sedan att delas in i tre kategorier:

- Kilobyte nedladdade per dag: Det indikerar de kilobyte som laddas ned av Googlebots när du besöker webbplatsen. Detta indikerar i princip två viktiga punkter: Om höga medelvärden visas i grafen betyder det att webbplatsen genomsöks oftare eller så kan det också indikera att boten tar lång tid att genomsöka en webbplats och att den inte är lätt.

- Sidor genomsökta per dag: Den talar om hur många sidor Googlebot genomsöker varje dag. Den noterar också statusen för genomsökningsaktiviteten oavsett om den är låg, hög eller genomsnittlig. Låg genomsökningshastighet indikerar att webbplatsen inte genomsöks ordentligt av Googlebot

- Tid för nedladdning av en sida (i millisekunder): Detta indikerar den tid det tar för Googlebot att göra HTTP-förfrågningar medan den genomsöker webbplatsen. Mindre tid Googlebot har att lägga på att göra förfrågningar, det blir bättre att ladda ner sidan eftersom indexeringen går snabbare.

Slutsats

Jag hoppas att du har fått ut mycket av den här guiden om loggfilsanalys och verktyg som används för att granska loggfilerna för SEO. Att granska loggfilerna kan vara mycket effektivt för att förbättra de tekniska SEO-aspekterna på webbplatsen.

Google Search Console och SEMrush Log File Analyzer är två alternativ för ett gratis och grundläggande analysverktyg. Som ett alternativ, kolla Screaming Frog Log File Analyzer, JetOctopus eller Oncrawl Log Analyzer för att bättre förstå hur sökmotorrobotar interagerar med din webbplats; du kan använda blandade premium- och gratisverktyg för analys av loggfiler för SEO.

Du kan också titta på några avancerade sökrobotar för att förbättra SEO.