Det finns terabyte och petabyte med data i denna internetålder, med exponentiell tillväxt på samma sätt. Men hur konsumerar vi denna data och översätter den till användbar information för att förbättra tjänsternas tillgänglighet?

Giltig, ny och begriplig data är allt företag behöver för sina modeller för kunskapsupptäckt.

Av denna anledning använder företag analyser på många olika sätt för att avslöja kvalitetsdata.

Men var börjar allt? Svaret är databråk.

Låt oss börja!

Innehållsförteckning

Vad är databråk?

Databråk är handlingen att rensa, strukturera och omvandla rådata till format som förenklar dataanalysprocesser. Databråk involverar ofta att arbeta med röriga och komplexa datamängder som inte är redo för datapipelineprocesser. Databråk flyttar rådata till ett förfinat tillstånd eller förfinat data till optimerat tillstånd och produktionsklar nivå.

Några av de kända uppgifterna i datastrid inkluderar:

- Sammanfoga flera datamängder till en stor datamängd för analys.

- Undersöker saknade/luckor i data.

- Ta bort extremvärden eller anomalier i datauppsättningar.

- Standardisera ingångar.

De stora datalagren som är involverade i processer för datatvistning är vanligtvis bortom manuell inställning, vilket kräver automatiserade databeredningsmetoder för att producera mer exakta och kvalitetsdata.

Mål för datatvistelse

Förutom att förbereda data för analys som det större målet, inkluderar andra mål:

- Skapa giltiga och nya data av rörig data för att driva beslutsfattande i företag.

- Standardisera rådata till format som Big Data-system kan ta in.

- Minska den tid som dataanalytiker spenderar när de skapar datamodeller genom att presentera ordnad data.

- Skapa konsekvens, fullständighet, användbarhet och säkerhet för alla datauppsättningar som konsumeras eller lagras i ett datalager.

Vanliga tillvägagångssätt för databråk

Upptäcker

Innan dataingenjörer börjar förbereda uppgifterna måste de förstå hur de lagras, storleken, vilka register som sparas, kodningsformaten och andra attribut som beskriver alla datauppsättningar.

Strukturering

Denna process innebär att organisera data för att ha lättanvändbara format. Rådatauppsättningar kan behöva struktureras i hur kolumnerna visas, antalet rader och justering av andra dataattribut för att förenkla analysen.

Rengöring

Strukturerade datauppsättningar måste bli av med inneboende fel och allt som kan förvränga data inom. Rengöring innebär alltså att ta bort flera cellposter med liknande data, ta bort tomma celler och outlierdata, standardisera indata, byta namn på förvirrande attribut och mer.

Anrikande

När data har passerat strukturerings- och rengöringsstadierna är det nödvändigt att bedöma datanyttan och utöka den med värden från andra datauppsättningar som saknar för att ge önskad datakvalitet.

Validerar

Valideringsprocessen innefattar iterativa programmeringsaspekter som belyser datakvalitet, konsistens, användbarhet och säkerhet. Valideringsfasen säkerställer att alla transformationsuppgifter uppnås och flaggar datamängder som redo för analys- och modelleringsfaser.

Presenterar

Efter att alla steg är klara presenteras/delas de krånglade datamängderna inom en organisation för analys. Dokumentation av förberedelsesteg och metadata som genereras under tvistningsprocessen delas också i detta skede.

Talend

Talend är en enhetlig datahanteringsplattform insvept i 3 datatyger för att tillhandahålla tillförlitlig och hälsosam data. Talend presenterar dataintegration, applikation och integration samt dataintegritet och styrning. Datatvistelse i Talend sker genom ett webbläsarbaserat peka och klicka-verktyg som möjliggör batch-, bulk- och livedataförberedelser – dataprofilering, rengöring och dokumentation.

Talend dataväv hanterar varje skede av datalivscykeln och balanserar noggrant datatillgänglighet, användbarhet, säkerhet och integritet för alla affärsdata.

Har du någonsin varit orolig för dina olika datakällor? Talends enhetliga tillvägagångssätt ger snabb dataintegration från alla dina datakällor (databaser, molnlagringar och API-slutpunkter) – vilket möjliggör transformation och kartläggning av all data med sömlösa kvalitetskontroller.

Dataintegration i Talend möjliggörs genom självbetjäningsverktyg som t.ex. kopplingar som gör att utvecklare kan mata in data från vilken källa som helst automatiskt och adekvat kategorisera data.

Funktioner i Talend

Universell dataintegration

Talend tillåter företag att tvista om vilken datatyp som helst från olika datakällor – moln eller lokala miljöer.

Flexibel

Talend går längre än leverantör eller plattform när du bygger datapipelines av din integrerade data. När du väl har skapat datapipelines av dina intagna data låter Talend dig köra pipelines var som helst.

Datakvalitet

Med maskininlärningsfunktioner som datadeduplicering, validering och standardisering rensar Talend intagen data automatiskt.

Stöd för applikations- och API-integrationer

Efter att mening har skapats av din data genom Talends självbetjäningsverktyg, kan du dela din data genom användarvänliga API:er. Talend API-slutpunkter kan exponera dina datatillgångar för SaaS-, JSON-, AVRO- och B2B-plattformar genom avancerade datakartläggnings- och transformationsverktyg.

R

R är ett välutvecklat och effektivt programmeringsspråk för att hantera utforskande dataanalys för vetenskapliga och affärsmässiga tillämpningar.

Byggd som fri programvara för statistisk beräkning och grafik, är R både ett språk och en miljö för datatvistelse, modellering och visualisering. R-miljön tillhandahåller en uppsättning mjukvarupaket medan R-språket integrerar en serie statistiska, klustrings-, klassificerings-, analys- och grafiska tekniker som hjälper till att manipulera data.

Funktioner hos R

Rik uppsättning paket

Dataingenjörer har mer än 10 000 standardiserade paket och tillägg att välja mellan från Comprehensive R Archive Network (CRAN). Detta förenklar gräl och dataanalys.

Extremt kraftfull

Med distribuerade datorpaket tillgängliga kan R utföra komplexa och enkla manipulationer (matematiska och statistiska) på dataobjekt och datauppsättningar inom några sekunder.

Cross-Platform Support

R är plattformsoberoende och kan köras på många operativsystem. Det är också kompatibelt med andra programmeringsspråk som hjälper till att manipulera beräkningstunga uppgifter.

Att lära sig R är lätt.

Trifacta

Trifacta är en interaktiv molnmiljö för profilering av data som körs mot maskininlärning och analysmodeller. Detta datateknikverktyg syftar till att skapa begriplig data oavsett hur rörig eller komplex datauppsättningarna är. Användare kan ta bort dubbla poster och fylla tomma celler i datauppsättningar genom deduplicering och linjära transformationstransformationer.

Det här verktyget för datatvistelse har ett öga för extremvärden och ogiltiga data i alla datauppsättningar. Med bara ett klick och en dragning rangordnas och omvandlas data till hands med hjälp av förslag som drivs av maskininlärning för att påskynda dataförberedelsen.

Databråk i Trifacta sker genom övertygande visuella profiler som kan ta emot icke-teknisk och teknisk personal. Med de visualiserade och intelligenta transformationerna är Trifacta stolt över sin design för användare i åtanke.

Oavsett om de tar in data från datamarts, datalager eller datasjöar, är användare skyddade från komplexiteten i dataförberedelser.

Funktioner hos Trifacta

Sömlösa molnintegrationer

Stöder förberedande arbetsbelastningar över alla moln- eller hybridmiljöer för att tillåta utvecklare att mata in datauppsättningar för gräl oavsett var de bor.

Flera data Standardiseringsmetoder

Trifacta wrangler har flera mekanismer för att identifiera mönster i data och standardisera utgångarna. Dataingenjörer kan välja standardisering efter mönster, efter funktion eller blanda och matcha.

Enkelt arbetsflöde

Trifacta organiserar databeredningsarbeten i form av flöden. Ett flöde innehåller en eller flera datamängder plus deras associerade recept (definierade steg som transformerar data).

Ett flöde minskar därför tiden som utvecklare spenderar när de importerar, bråkar, profilerar och exporterar data.

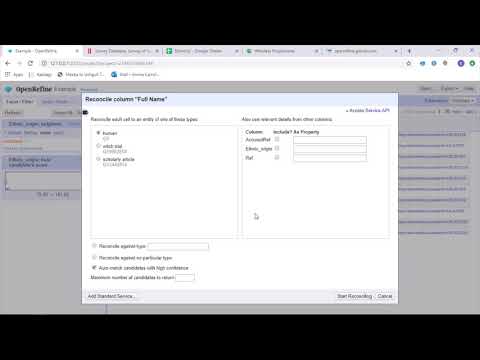

OpenRefine

OpenRefine är ett moget, öppen källkodsverktyg för att arbeta med rörig data. Som ett datarensningsverktyg utforskar OpenRefine datauppsättningar på några sekunder samtidigt som komplexa celltransformationer används för att presentera önskade dataformat.

OpenRefine närmar sig databråk genom filter och partitioner på datauppsättningar med hjälp av reguljära uttryck. Genom att använda det inbyggda General Refine Expression Language kan dataingenjörer lära sig och visa data med hjälp av fasetter, filter och sorteringstekniker innan de utför avancerade dataoperationer för enhetsextraktioner.

OpenRefine tillåter användare att arbeta med data som projekt där datamängder från flera datorfiler, webbadresser och databaser kan dras in i sådana projekt med möjligheten att köras lokalt på användarnas maskiner.

Genom uttryck kan utvecklare utöka datarensning och transformation till uppgifter som att dela upp/sammanfoga celler med flera värden, anpassa aspekter och hämta data till kolumner med hjälp av externa webbadresser.

Funktioner i OpenRefine

Plattformsverktyg

OpenRefine är byggd för att fungera med Windows, Mac och Linux operativsystem genom nedladdningsbara installationsinställningar.

Rik uppsättning API:er

Har OpenRefine API, datatilläggs-API, avstämnings-API och andra API:er som stödjer användarnas interaktion med data.

Datameer

Datameer är ett SaaS-datatransformationsverktyg byggt för att förenkla datamunging och integration genom programvaruutvecklingsprocesser. Datameer möjliggör extrahering, transformation och laddning av datauppsättningar till molndatalager som Snowflake.

Det här verktyget för databråk fungerar bra med standarddatauppsättningsformat som CSV och JSON, vilket gör att ingenjörer kan importera data i olika format för aggregering.

Datameer har katalogliknande datadokumentation, djup dataprofilering och upptäckt för att möta alla datatransformationsbehov. Verktyget har en djup visuell dataprofil som gör det möjligt för användare att spåra ogiltiga, saknade eller avlägsna fält och värden och den övergripande formen på data.

Datameer körs på ett skalbart datalager och transformerar data för meningsfull analys genom effektiva datastackar och excelliknande funktioner.

Datameer presenterar ett hybrid-, kod- och no-code användargränssnitt för att rymma breda dataanalysteam som enkelt kan bygga komplexa ETL-pipelines.

Funktioner i Datameer

Flera användarmiljöer

Innehåller miljöer för multi-person datatransformation – låg kod, kod och hybrid, för att stödja tekniskt kunniga och icke-tekniska personer.

Delade arbetsytor

Datameer låter team återanvända och samarbeta om modeller för att påskynda projekt.

Riklig datadokumentation

Datameer stöder både system- och användargenererad datadokumentation genom metadata och beskrivningar, taggar och kommentarer i wiki-stil.

Sista ord 👩🏫

Dataanalys är en komplex process som kräver att data är korrekt organiserade för att dra meningsfulla slutsatser och göra förutsägelser. Data Wrangling-verktyg hjälper dig att formatera stora mängder rådata för att hjälpa dig utföra avancerad analys. Välj det bästa verktyget som passar dina krav och bli ett Analytics-proffs!

Du må gilla:

Bästa CSV-verktyg för att konvertera, formatera och validera.