Att bygga en maskininlärningsmodell är relativt enkelt. Att skapa hundratals eller tusentals modeller och iterera över befintliga är svårt.

Det är lätt att gå vilse i kaoset. Detta kaos förvärras när man arbetar som ett team, eftersom man nu måste hålla koll på vad alla gör. För att få ordning på kaoset krävs att hela teamet följer en process och dokumenterar sina aktiviteter. Detta är kärnan i MLOps.

Innehållsförteckning

Vad är MLOps?

Källa: ml-ops.org

Enligt MLOps.org försöker Machine Learning Operationalization bygga en heltäckande maskininlärningsutvecklingsprocess för att designa, bygga och hantera reproducerbar, testbar och utvecklingsbar ML-driven programvara. I huvudsak är MLOps DevOps-principer som tillämpas på maskininlärning.

Liksom DevOps är nyckelidén med MLOps automatisering för att minska manuella steg och öka effektiviteten. Liksom DevOps inkluderar MLOps både Continuous Integration (CI) och Continuous Delivery (CD). Utöver dessa två inkluderar det också kontinuerlig träning (CT). Den ytterligare aspekten av CT involverar omskolning av modeller med nya data och omdistribuering av dem.

MLOps är därför en ingenjörskultur som främjar ett metodiskt förhållningssätt till utveckling av maskininlärningsmodeller och automatisering av olika steg i metoden. Processen innefattar i första hand dataextraktion, analys, förberedelse, modellutbildning, utvärdering, modellservering och övervakning.

Fördelar med MLOps

Generellt sett är fördelarna med att tillämpa MLOps-principer desamma som fördelarna med att ha standardoperativa procedurer. Fördelarna är följande:

- En väldefinierad process ger en färdplan över alla avgörande steg som ska tas i modellutvecklingen. Detta säkerställer att inga kritiska steg missas.

- Steg i processen som kan automatiseras kan identifieras och automatiseras. Detta minskar mängden repetitivt arbete och ökar utvecklingshastigheten. Det eliminerar också mänskliga fel samtidigt som det minskar mängden arbete som måste göras.

- Det blir lättare att bedöma framstegen i en modells utveckling genom att veta i vilket stadium av pipelinen modellen befinner sig.

- Det är lättare för team att kommunicera eftersom det finns ett gemensamt ordförråd för steg som ska tas under utvecklingen.

- Processen kan tillämpas upprepade gånger för att utveckla många modeller, vilket ger ett sätt att hantera kaoset.

Så i slutändan är MLOps roll i maskininlärning att tillhandahålla ett metodiskt tillvägagångssätt för modellutveckling som kan automatiseras så mycket som möjligt.

Plattformar för att bygga rörledningar

För att hjälpa dig att implementera MLOps i dina pipelines kan du använda en av de många plattformarna som vi kommer att diskutera här. Även om de individuella funktionerna för dessa plattformar kan vara olika, hjälper de dig i huvudsak att göra följande:

- Lagra alla dina modeller tillsammans med tillhörande modellmetadata – som konfigurationer, kod, noggrannhet och experiment. Det inkluderar även de olika versionerna av dina modeller för versionskontroll.

- Lagra datasetmetadata, till exempel data som användes för att träna modeller.

- Övervaka modeller i produktion för att fånga problem som modelldrift.

- Distribuera modeller till produktion.

- Bygg modeller i miljöer med låg kod eller ingen kod.

Låt oss utforska de bästa MLOps-plattformarna.

MLFlow

MLFlow är kanske den mest populära plattformen för Machine Learning Lifecycle Management. Det är gratis och öppen källkod. Den tillhandahåller följande funktioner:

- spårning för att registrera dina maskininlärningsexperiment, kod, data, konfigurationer och slutresultat;

- projekt för att paketera din kod i ett format som är lätt att reproducera;

- implementering för att distribuera din maskininlärning;

- ett register för att lagra alla dina modeller i ett centralt arkiv

MLFlow integreras med populära maskininlärningsbibliotek som TensorFlow och PyTorch. Den integreras också med plattformar som Apache Spark, H20.asi, Google Cloud, Amazon Sage Maker, Azure Machine Learning och Databricks. Det fungerar också med olika molnleverantörer som AWS, Google Cloud och Microsoft Azure.

Azure Machine Learning

Azure Machine Learning är en end-to-end maskininlärningsplattform. Den hanterar de olika maskinlivscykelaktiviteterna i din MLOPs pipeline. Dessa aktiviteter inkluderar dataförberedelse, byggande och utbildningsmodeller, validering och implementering av modeller samt hantering och övervakning av implementeringar.

Med Azure Machine Learning kan du bygga modeller med din föredragna IDE och ditt ramverk, PyTorch eller TensorFlow.

Den integreras också med ONNX Runtime och Deepspeed för att optimera din träning och slutledning. Detta förbättrar prestandan. Den utnyttjar AI-infrastruktur på Microsoft Azure som kombinerar NVIDIA GPU:er och Mellanox-nätverk för att hjälpa dig bygga maskininlärningskluster. Med AML kan du skapa ett centralt register för att lagra och dela modeller och datauppsättningar.

Azure Machine Learning integreras med Git och GitHub Actions för att bygga arbetsflöden. Den stöder också en hybrid- eller multimolnkonfiguration. Du kan också integrera det med andra Azure-tjänster som Synapse Analytics, Data Lake, Databricks och Security Center.

Google Vertex AI

Google Vertex AI är en enhetlig data- och AI-plattform. Den ger dig de verktyg du behöver för att bygga skräddarsydda och förutbildade modeller. Det fungerar också som en helhetslösning för implementering av MLOps. För att göra det enklare att använda, integreras det med BigQuery, Dataproc och Spark för sömlös dataåtkomst under träning.

Utöver API:et tillhandahåller Google Vertex AI en verktygsmiljö med låg kod och ingen kod så att den kan användas av icke-utvecklare som affärs- och dataanalytiker och ingenjörer. API:et gör det möjligt för utvecklare att integrera det med befintliga system.

Med Google Vertex AI kan du också bygga generativa AI-appar med Generative AI Studio. Det gör det enkelt och snabbt att distribuera och hantera infrastruktur. De idealiska användningsfallen för Google Vertex AI inkluderar att säkerställa databeredskap, funktionsteknik, utbildning och hyperparameterjustering, modellservering, modellinställning och förståelse, modellövervakning och modellhantering.

Databricks

Databricks är ett datasjöhus som gör att du kan förbereda och bearbeta data. Med Databricks kan du hantera hela livscykeln för maskininlärning från experiment till produktion.

Databricks tillhandahåller i huvudsak hanterat MLFlow med funktioner som dataloggningsannonsversion av ML-modeller, experimentspårning, modellvisning, ett modellregister och spårning av annonsmått. Modellregistret gör att du kan lagra modeller för reproducerbarhet, och registret hjälper dig att hålla reda på versioner i vilket skede av livscykeln de befinner sig i.

Att distribuera modeller med Dataricks kan göras med bara ett enda klick, och du kommer att ha REST API-slutpunkter att använda för att göra förutsägelser. Bland andra modeller integrerar den väl med befintliga förtränade generativa och stora språkmodeller, såsom de från biblioteket för kramas ansiktstransformatorer.

Dataricks tillhandahåller samverkande Databricks-anteckningsböcker som stöder Python, R, SQL och Scala. Dessutom förenklar det hanteringen av infrastruktur genom att tillhandahålla förkonfigurerade kluster som är optimerade för maskininlärningsuppgifter.

AWS SageMaker

AWS SageMaker är en AWS-molntjänst som ger dig de verktyg du behöver för att utveckla, träna och distribuera dina maskininlärningsmodeller. Det primära syftet med SageMaker är att automatisera det tråkiga och repetitiva manuella arbetet som ingår i att bygga en maskininlärningsmodell.

Som ett resultat ger det dig verktyg för att bygga en produktionspipeline för dina maskininlärningsmodeller med hjälp av olika AWS-tjänster, såsom Amazon EC2-instanser och Amazon S3-lagring.

SageMaker fungerar med Jupyter Notebooks installerade på en EC2-instans tillsammans med alla vanliga paket och bibliotek som behövs för att koda en maskininlärningsmodell. För data kan SageMaker hämta data från Amazon Simple Storage Service.

Som standard får du implementeringar av vanliga maskininlärningsalgoritmer som linjär regression och bildklassificering. SageMaker kommer också med en modellmonitor för att ge kontinuerlig och automatisk inställning för att hitta den uppsättning parametrar som ger bästa prestanda för dina modeller. Implementeringen är också förenklad, eftersom du enkelt kan distribuera din modell till AWS som en säker HTTP-slutpunkt som du kan övervaka med CloudWatch.

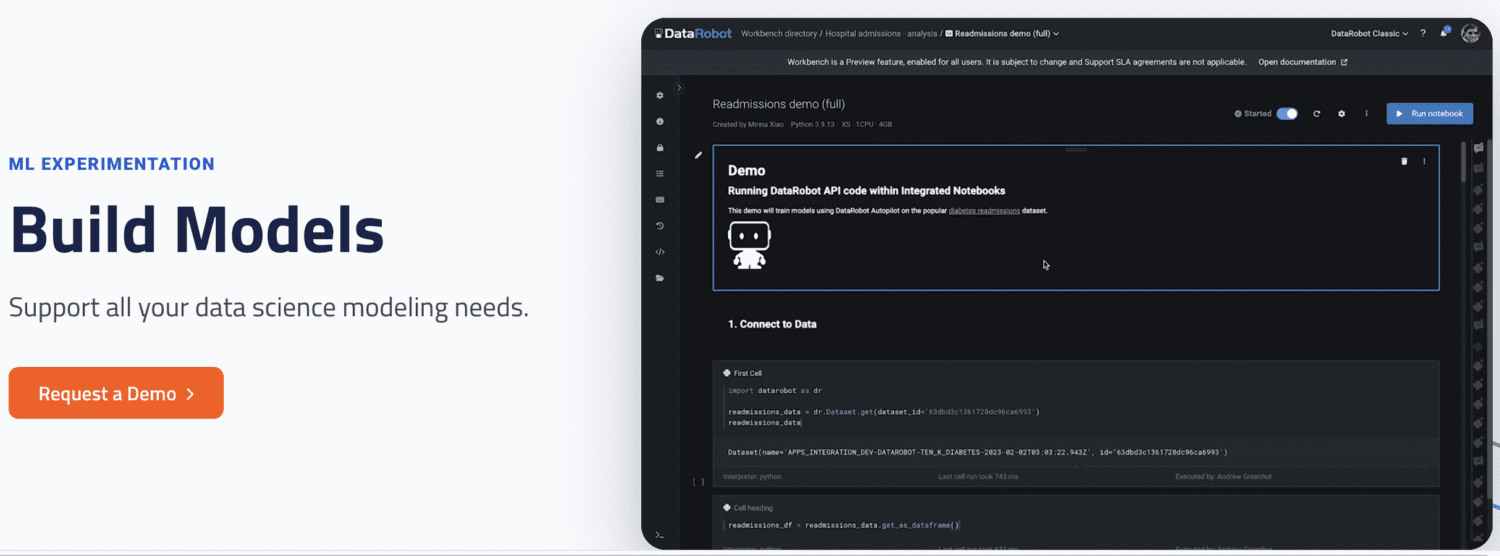

DataRobot

DataRobot är en populär MLOps-plattform som tillåter hantering över olika stadier av Machine Learning-livscykeln, såsom dataförberedelse, ML-experimentering, validering och styrande modeller.

Den har verktyg för att automatisera pågående experiment med olika datakällor, testa tusentals modeller och utvärdera de bästa för att distribuera till produktion. Det stöder att bygga modeller för olika typer av AI-modeller för att lösa problem i tidsserier, naturlig språkbehandling och datorseende.

Med DataRobot kan du bygga med out-of-the-box-modeller, så du behöver inte skriva kod. Alternativt kan du välja en kod först och implementera modeller med anpassad kod.

DataRobot kommer med anteckningsböcker för att skriva och redigera koden. Alternativt kan du använda API så att du kan utveckla modeller i en IDE som du väljer. Med hjälp av GUI kan du spåra experimenten för dina modeller.

Kör AI

Kör AI försöker lösa problemet med underutnyttjande av AI-infrastruktur, särskilt GPU:er. Det löser detta problem genom att främja synligheten av all infrastruktur och se till att den utnyttjas under utbildningen.

För att utföra detta sitter Run AI mellan din MLOps-programvara och företagets hårdvara. Medan du ockuperar detta lager körs alla träningsjobb med Run AI. Plattformen schemalägger i sin tur när vart och ett av dessa jobb körs.

Det finns ingen begränsning för huruvida hårdvaran måste vara molnbaserad, såsom AWS och Google Cloud, lokalt eller en hybridlösning. Det ger ett lager av abstraktion till maskininlärningsteam genom att fungera som en GPU-virtualiseringsplattform. Du kan köra uppgifter från Jupyter Notebook, bash-terminal eller fjärransluten PyCharm.

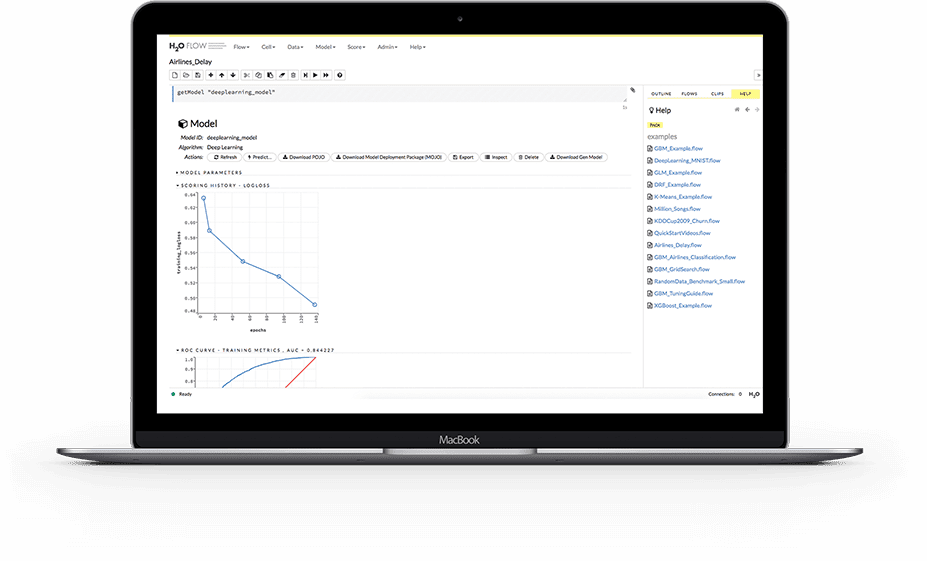

H2O.ai

H2O är en distribuerad maskininlärningsplattform med öppen källkod. Det gör det möjligt för team att samarbeta och skapa ett centralt arkiv för modeller där dataforskare kan experimentera och jämföra olika modeller.

Som en MLOps-plattform erbjuder H20 ett antal nyckelfunktioner. För det första förenklar H2O också modelldistribution till en server som en REST-slutpunkt. Den tillhandahåller olika distributionsämnen som A/B-test, Champoion-Challenger-modeller och enkel implementering av en modell.

Under utbildningen lagrar och hanterar den data, artefakter, experiment, modeller och implementeringar. Detta gör att modellerna är reproducerbara. Det möjliggör också behörighetshantering på grupp- och användarnivå för att styra modeller och data. Medan modellen körs tillhandahåller H2O även realtidsövervakning för modelldrift och andra driftsmått.

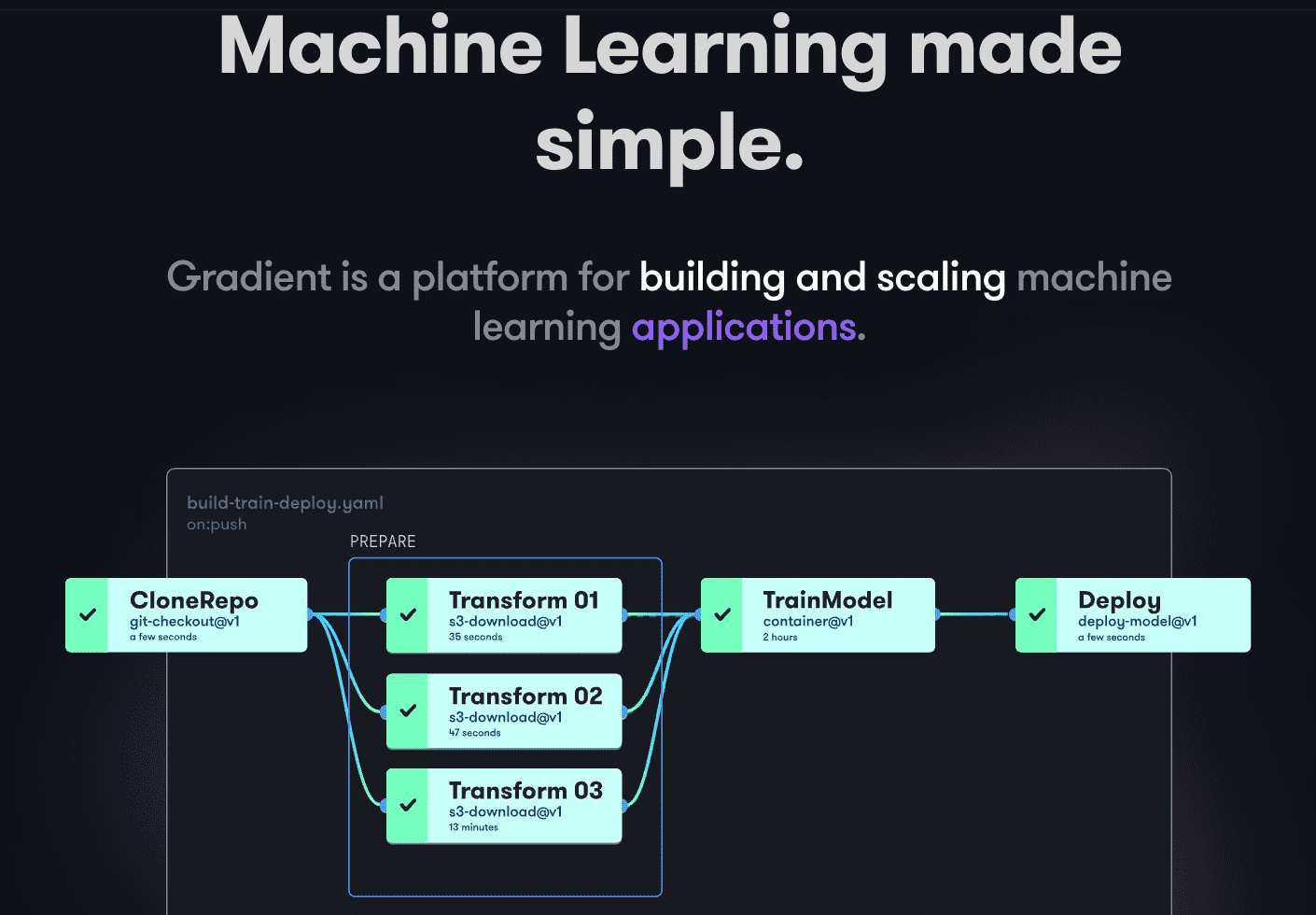

Paperspace Gradient

Gradient hjälper utvecklare i alla stadier av Machine Learning-utvecklingscykeln. Den tillhandahåller bärbara datorer som drivs av Jupyter med öppen källkod för modellutveckling och träning i molnet med kraftfulla GPU:er. Detta gör att du snabbt kan utforska och prototypa modeller.

Implementeringspipelines kan automatiseras genom att skapa arbetsflöden. Dessa arbetsflöden definieras genom att beskriva uppgifter i YAML. Genom att använda arbetsflöden blir det lätt att replikera implementeringar och visningsmodeller och därför skalbara som ett resultat.

Som helhet tillhandahåller Gradient behållare, maskiner, data, modeller, mätvärden, loggar och hemligheter för att hjälpa dig hantera olika stadier av utvecklingspipelinen för Machine Learning-modeller. Dina pipelines körs på Gradiet-kluster. Dessa kluster finns antingen på Paperspace Cloud, AWS, GCP, Azure eller andra servrar. Du kan interagera med Gradient med hjälp av CLI eller SDK programmatiskt.

Slutord

MLOps är ett kraftfullt och mångsidigt sätt att bygga, distribuera och hantera maskininlärningsmodeller i stor skala. MLOps är lätt att använda, skalbar och säker, vilket gör det till ett bra val för organisationer av alla storlekar.

I den här artikeln tog vi upp MLOPs, varför det är viktigt att implementera dem, vad som är inblandat och de olika populära MLOps-plattformarna.

Därefter kanske du vill läsa vår jämförelse av Dataricks vs. Snowflake.